Préface

Vous vous demandez peut-être qui nous sommes et pourquoi nous avons écrit ce livre.

À la fin du dernier livre de Harry, Test-Driven Development with Python (O’Reilly), il s’est retrouvé à se poser un tas de questions sur l’architecture, telles que : Quelle est la meilleure façon de structurer votre application pour qu’elle soit facile à tester ? Plus précisément, pour que votre logique métier centrale soit couverte par des tests unitaires, et pour que vous minimisiez le nombre de tests d’intégration et de bout en bout dont vous avez besoin ? Il a fait de vagues références à "Hexagonal Architecture" (Architecture Hexagonale) et "Ports and Adapters" (Ports et Adaptateurs) et "Functional Core, Imperative Shell" (Noyau Fonctionnel, Enveloppe Impérative), mais pour être honnête, il devrait admettre que ce n’étaient pas des choses qu’il comprenait vraiment ou qu’il avait pratiquées.

Et puis il a eu la chance de rencontrer Bob, qui a les réponses à toutes ces questions.

Bob est devenu architecte logiciel parce que personne d’autre dans son équipe ne le faisait. Il s’est avéré qu’il était plutôt mauvais dans ce domaine, mais lui a eu la chance de rencontrer Ian Cooper, qui lui a enseigné de nouvelles façons d’écrire et de penser le code.

Gérer la Complexité, Résoudre les Problèmes Métier

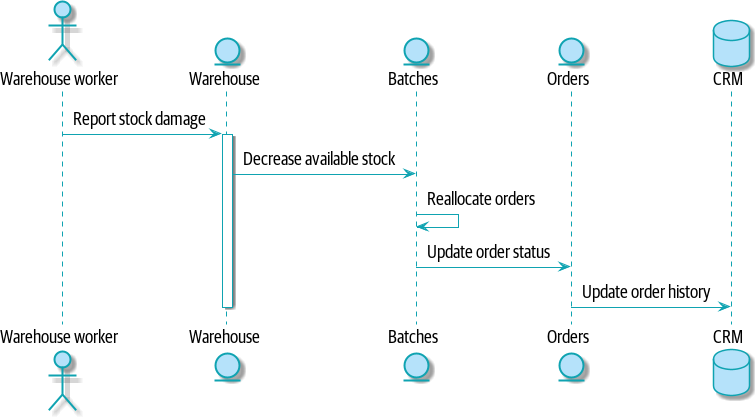

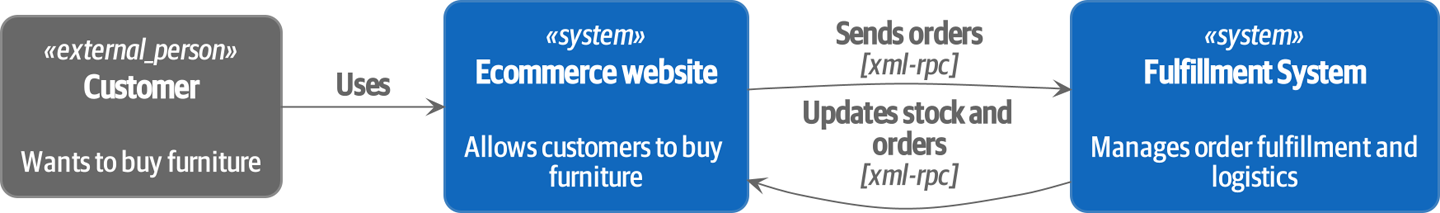

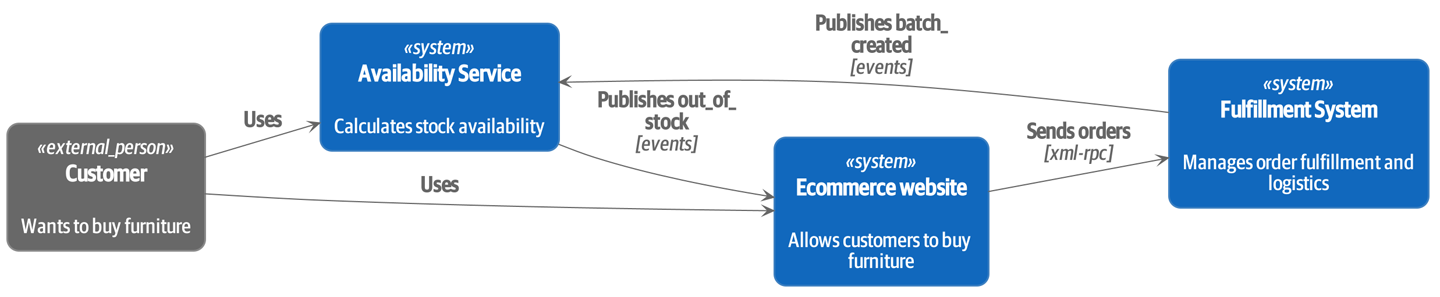

Nous travaillons tous deux pour MADE.com, une entreprise de commerce électronique européenne qui vend des meubles en ligne ; là-bas, nous appliquons les techniques de ce livre pour construire des systèmes distribués qui modélisent les problèmes métier du monde réel. Notre domaine d’exemple est le premier système que Bob a construit pour MADE, et ce livre est une tentative de mettre par écrit tout ce truc que nous devons enseigner aux nouveaux programmeurs lorsqu’ils rejoignent l’une de nos équipes.

MADE.com gère une chaîne d’approvisionnement mondiale de partenaires de fret et de fabricants. Pour maintenir les coûts bas, nous essayons d’optimiser la livraison de stock vers nos entrepôts afin de ne pas avoir de marchandises invendues qui traînent.

Idéalement, le canapé que vous voulez acheter arrivera au port le jour même où vous décidez de l’acheter, et nous le livrerons directement chez vous sans jamais le stocker. Avoir le bon timing est un exercice d’équilibre délicat lorsque les marchandises prennent trois mois pour arriver par porte-conteneurs. En chemin, les choses se cassent ou sont endommagées par l’eau, les tempêtes causent des retards inattendus, les partenaires logistiques manipulent mal les marchandises, la paperasse disparaît, les clients changent d’avis et modifient leurs commandes, et ainsi de suite.

Nous résolvons ces problèmes en construisant des logiciels intelligents représentant les types d’opérations qui se déroulent dans le monde réel afin de pouvoir automatiser autant que possible l’activité.

Pourquoi Python ?

Si vous lisez ce livre, nous n’avons probablement pas besoin de vous convaincre que Python est génial, donc la vraie question est "Pourquoi la communauté Python a-t-elle besoin d’un livre comme celui-ci ?" La réponse concerne la popularité et la maturité de Python : bien que Python soit probablement le langage de programmation à la croissance la plus rapide au monde et s’approche du sommet des tableaux de popularité absolue, il ne fait que commencer à prendre en charge les types de problèmes sur lesquels le monde C# et Java travaille depuis des années. Les startups deviennent de vraies entreprises ; les applications web et les automatisations scriptées deviennent (chuchotons-le) des logiciels d’entreprise.

Dans le monde Python, nous citons souvent le Zen de Python : "Il devrait y avoir une—et de préférence une seule—manière évidente de le faire."[1] Malheureusement, à mesure que la taille du projet augmente, la manière la plus évidente de faire les choses n’est pas toujours celle qui vous aide à gérer la complexité et l’évolution des exigences.

Aucune des techniques et patterns dont nous discutons dans ce livre n’est nouvelle, mais elles sont pour la plupart nouvelles dans le monde Python. Et ce livre n’est pas un remplacement des classiques du domaine tels que le Domain-Driven Design d’Eric Evans ou les Patterns of Enterprise Application Architecture de Martin Fowler (tous deux publiés par Addison-Wesley Professional)—que nous référençons souvent et vous encourageons à aller lire.

Mais tous les exemples de code classiques de la littérature ont tendance à être écrits en Java ou C++/#, et si vous êtes une personne Python et n’avez pas utilisé l’un de ces langages depuis longtemps (ou même jamais), ces listings de code peuvent être assez…éprouvants. Il y a une raison pour laquelle la dernière édition de cet autre texte classique, le Refactoring de Fowler (Addison-Wesley Professional), est en JavaScript.

TDD, DDD, et Architecture Événementielle

Par ordre de notoriété, nous connaissons trois outils pour gérer la complexité :

-

Le Développement Piloté par les Tests (Test-driven development - TDD) nous aide à construire du code correct et nous permet de refactoriser ou d’ajouter de nouvelles fonctionnalités, sans crainte de régression. Mais il peut être difficile de tirer le meilleur parti de nos tests : Comment nous assurer qu’ils s’exécutent aussi rapidement que possible ? Que nous obtenons autant de couverture et de retour de tests unitaires rapides et sans dépendances et avons le minimum de tests de bout en bout plus lents et instables ?

-

La Conception Pilotée par le Domaine (Domain-driven design - DDD) nous demande de concentrer nos efforts sur la construction d’un bon modèle du domaine métier, mais comment nous assurer que nos modèles ne sont pas encombrés de préoccupations d’infrastructure et ne deviennent pas difficiles à modifier ?

-

Les (micro)services faiblement couplés intégrés via des messages (parfois appelés microservices réactifs) sont une réponse bien établie à la gestion de la complexité à travers plusieurs applications ou domaines métier. Mais il n’est pas toujours évident de les faire fonctionner avec les outils établis du monde Python—Flask, Django, Celery, et ainsi de suite.

| Ne soyez pas découragé si vous ne travaillez pas avec (ou n’êtes pas intéressé par) les microservices. La grande majorité des patterns dont nous discutons, y compris une grande partie du matériel sur l’architecture événementielle, est absolument applicable dans une architecture monolithique. |

Notre objectif avec ce livre est d’introduire plusieurs patterns architecturaux classiques et de montrer comment ils soutiennent TDD, DDD, et les services événementiels. Nous espérons qu’il servira de référence pour les implémenter de manière Pythonique, et que les gens pourront l’utiliser comme première étape vers des recherches plus approfondies dans ce domaine.

Qui Devrait Lire Ce Livre

Voici quelques éléments que nous supposons vous concernant, cher lecteur :

-

Vous avez côtoyé des applications Python raisonnablement complexes.

-

Vous avez vu une partie de la douleur qui vient avec la tentative de gérer cette complexité.

-

Vous ne connaissez pas nécessairement quoi que ce soit sur DDD ou l’un des patterns d’architecture d’application classiques.

Nous structurons nos explorations des patterns architecturaux autour d’une application d’exemple, en la construisant chapitre par chapitre. Nous utilisons le TDD au travail, donc nous avons tendance à montrer d’abord les listings de tests, suivis de l’implémentation. Si vous n’êtes pas habitué à travailler en test-first, cela peut sembler un peu étrange au début, mais nous espérons que vous vous habituerez bientôt à voir le code "être utilisé" (c’est-à-dire, de l’extérieur) avant de voir comment il est construit à l’intérieur.

Nous utilisons certains frameworks et technologies Python spécifiques, notamment Flask, SQLAlchemy, et pytest, ainsi que Docker et Redis. Si vous êtes déjà familier avec eux, cela n’entravera pas, mais nous ne pensons pas que ce soit requis. L’un de nos principaux objectifs avec ce livre est de construire une architecture pour laquelle les choix technologiques spécifiques deviennent des détails d’implémentation mineurs.

Un Bref Aperçu de Ce Que Vous Apprendrez

Le livre est divisé en deux parties ; voici un aperçu des sujets que nous couvrirons et des chapitres dans lesquels ils se trouvent.

#part1

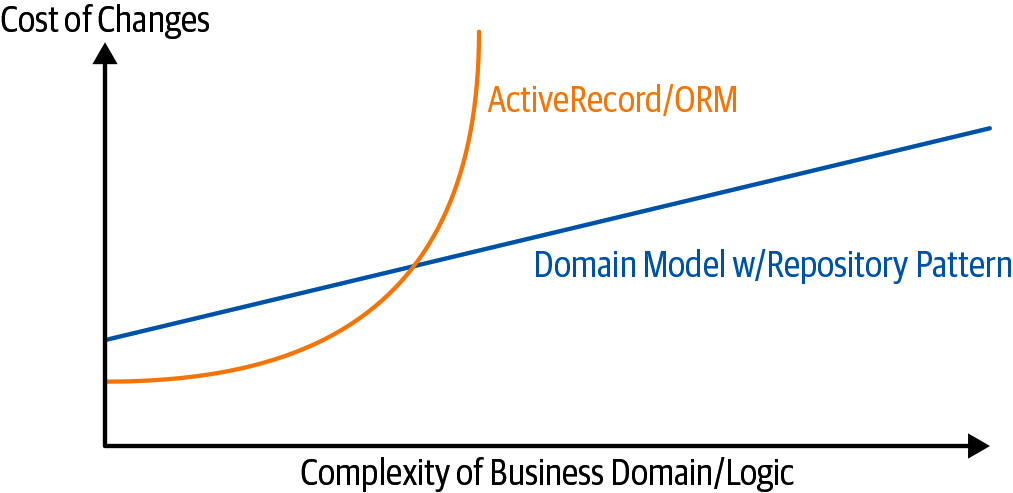

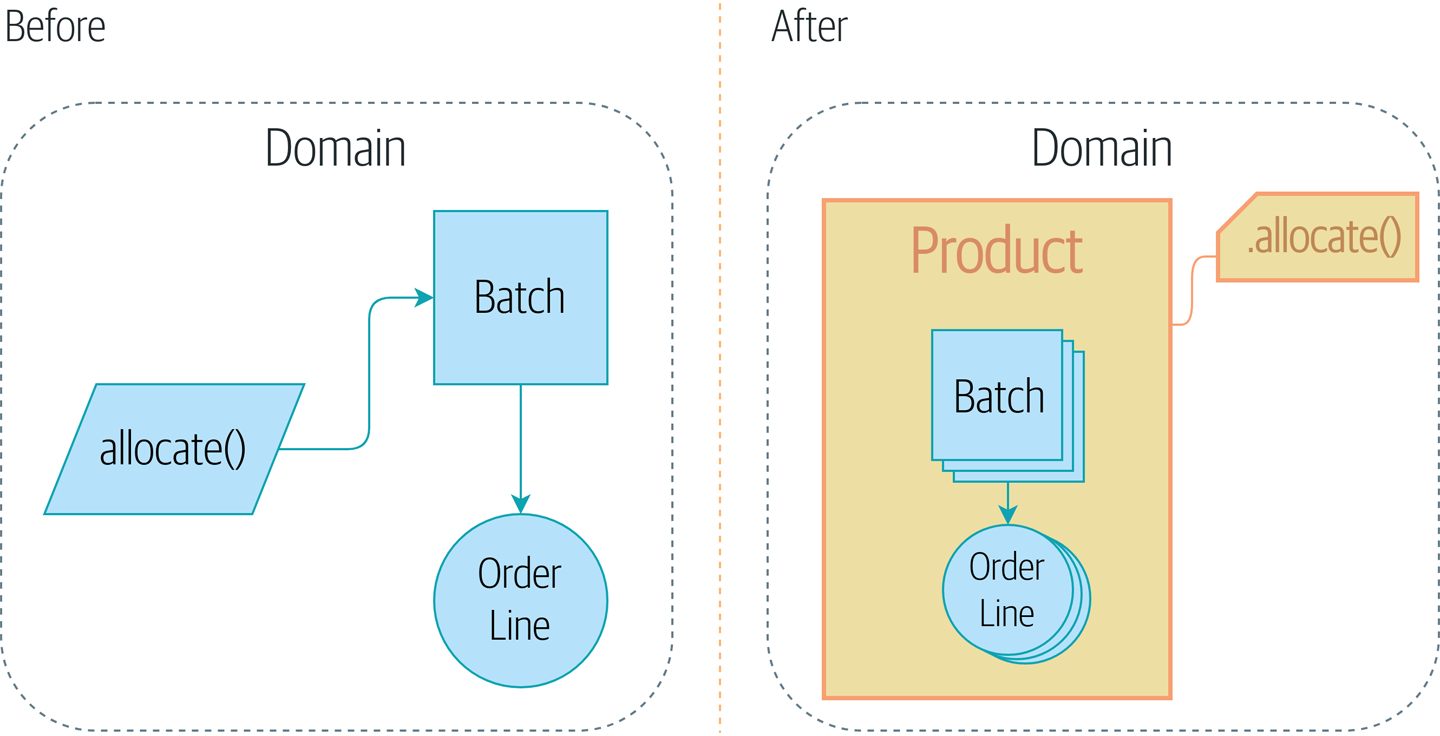

- Modélisation de domaine et DDD (Chapitres 1, 2 et 7)

-

À un certain niveau, tout le monde a appris la leçon que les problèmes métier complexes doivent être reflétés dans le code, sous la forme d’un modèle du domaine. Mais pourquoi semble-t-il toujours si difficile de le faire sans s’emmêler avec des préoccupations d’infrastructure, nos frameworks web, ou quoi que ce soit d’autre ? Dans le premier chapitre, nous donnons un aperçu large de la modélisation de domaine et du DDD, et nous montrons comment démarrer avec un modèle qui n’a pas de dépendances externes, et des tests unitaires rapides. Plus tard, nous revenons aux patterns DDD pour discuter de comment choisir le bon agrégat (aggregate), et comment ce choix se rapporte aux questions d’intégrité des données.

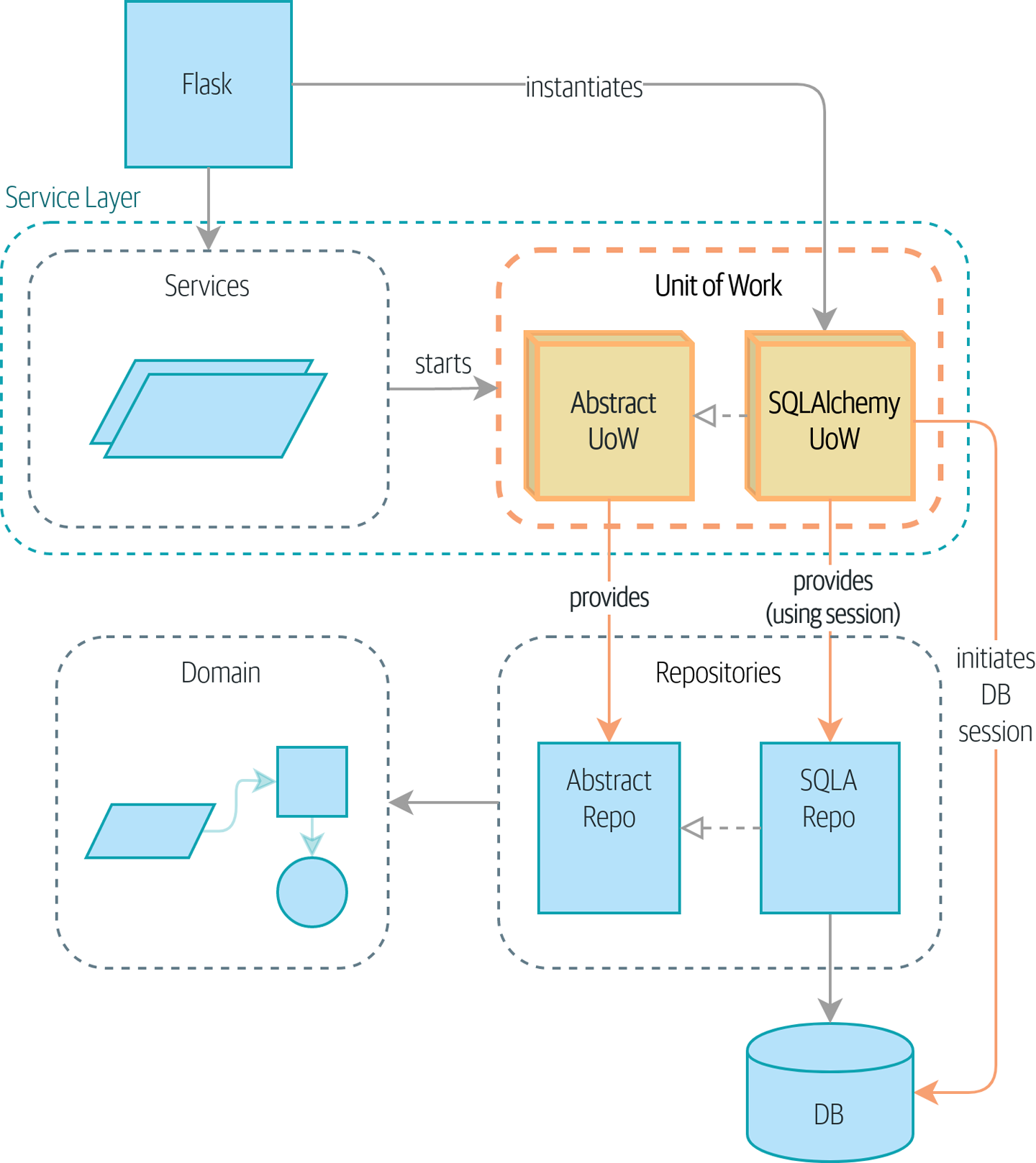

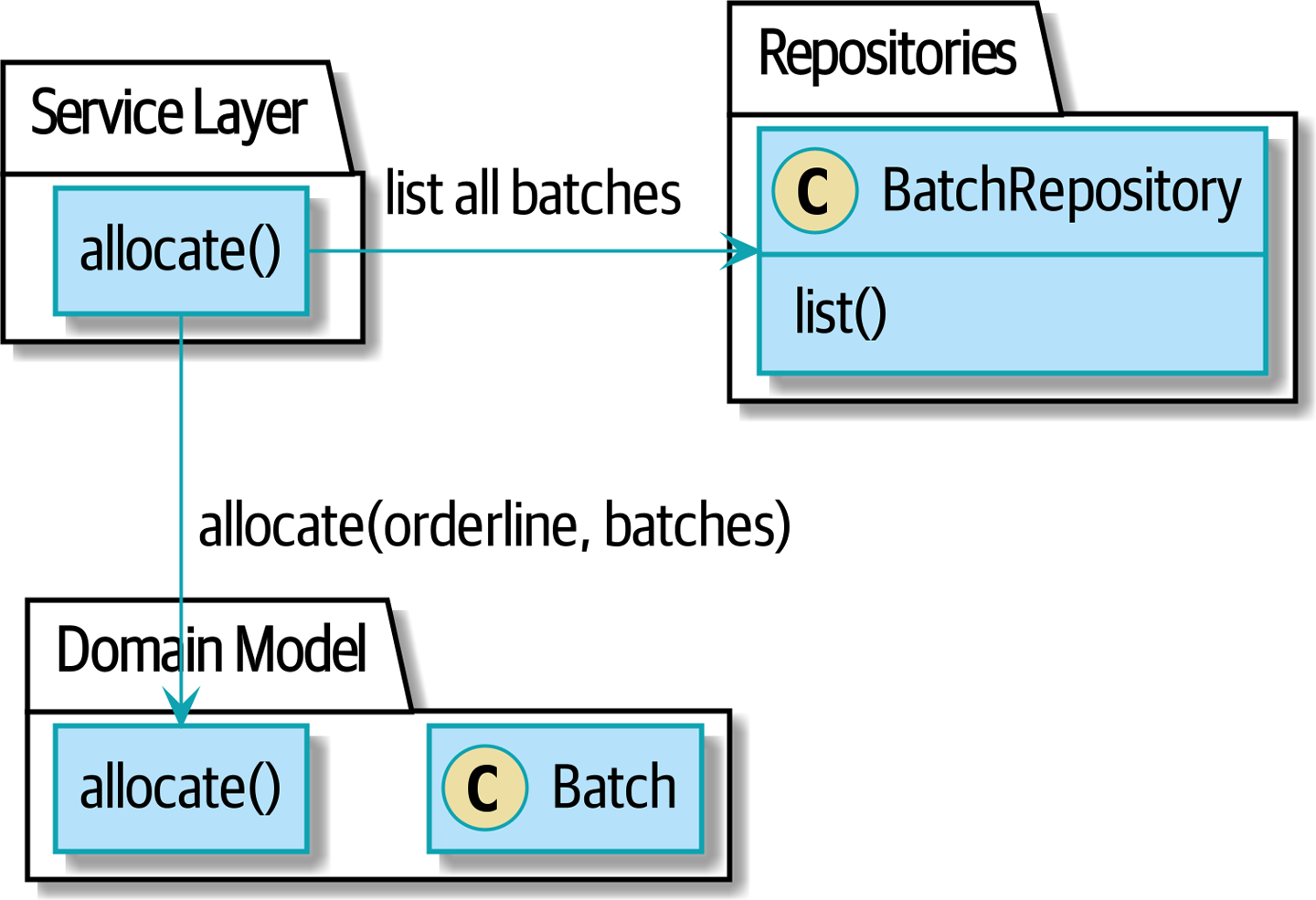

- Patterns Dépôt (Repository), Couche de Service (Service Layer), et Unité de Travail (Unit of Work) (Chapitres 2, 4, et 5)

-

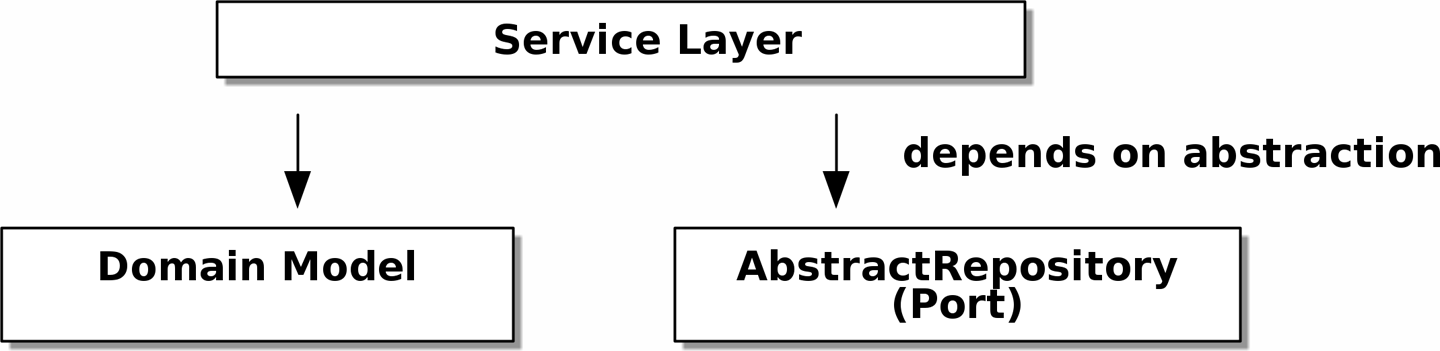

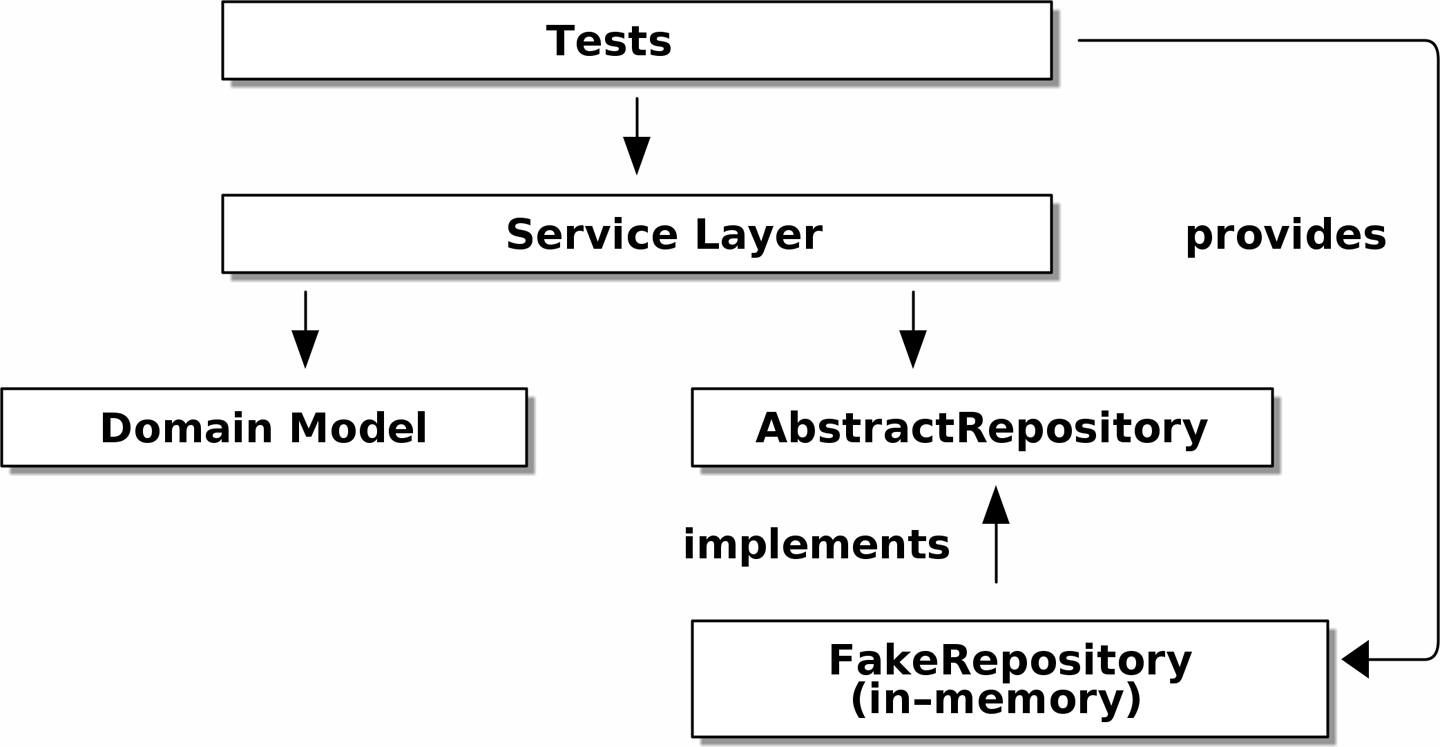

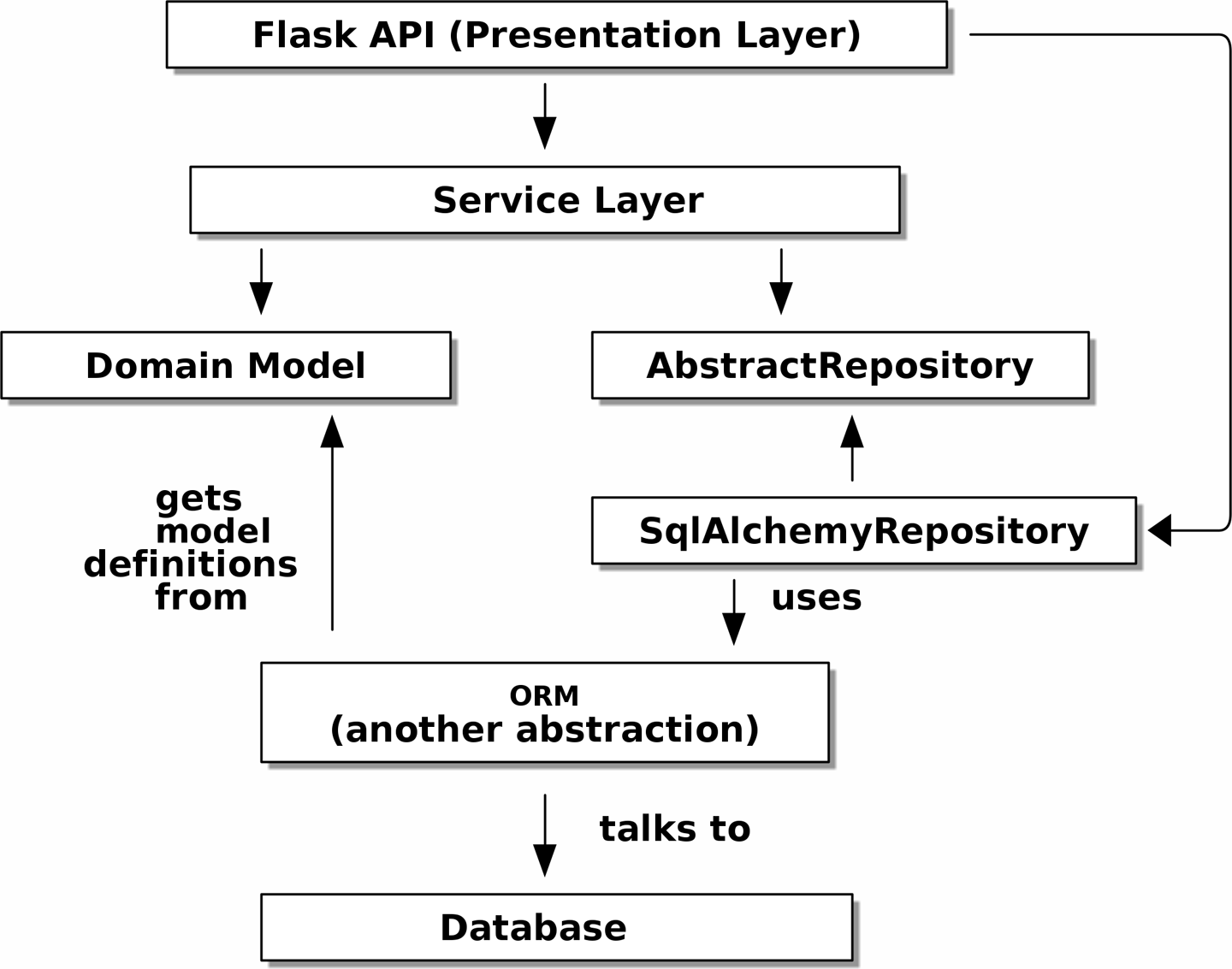

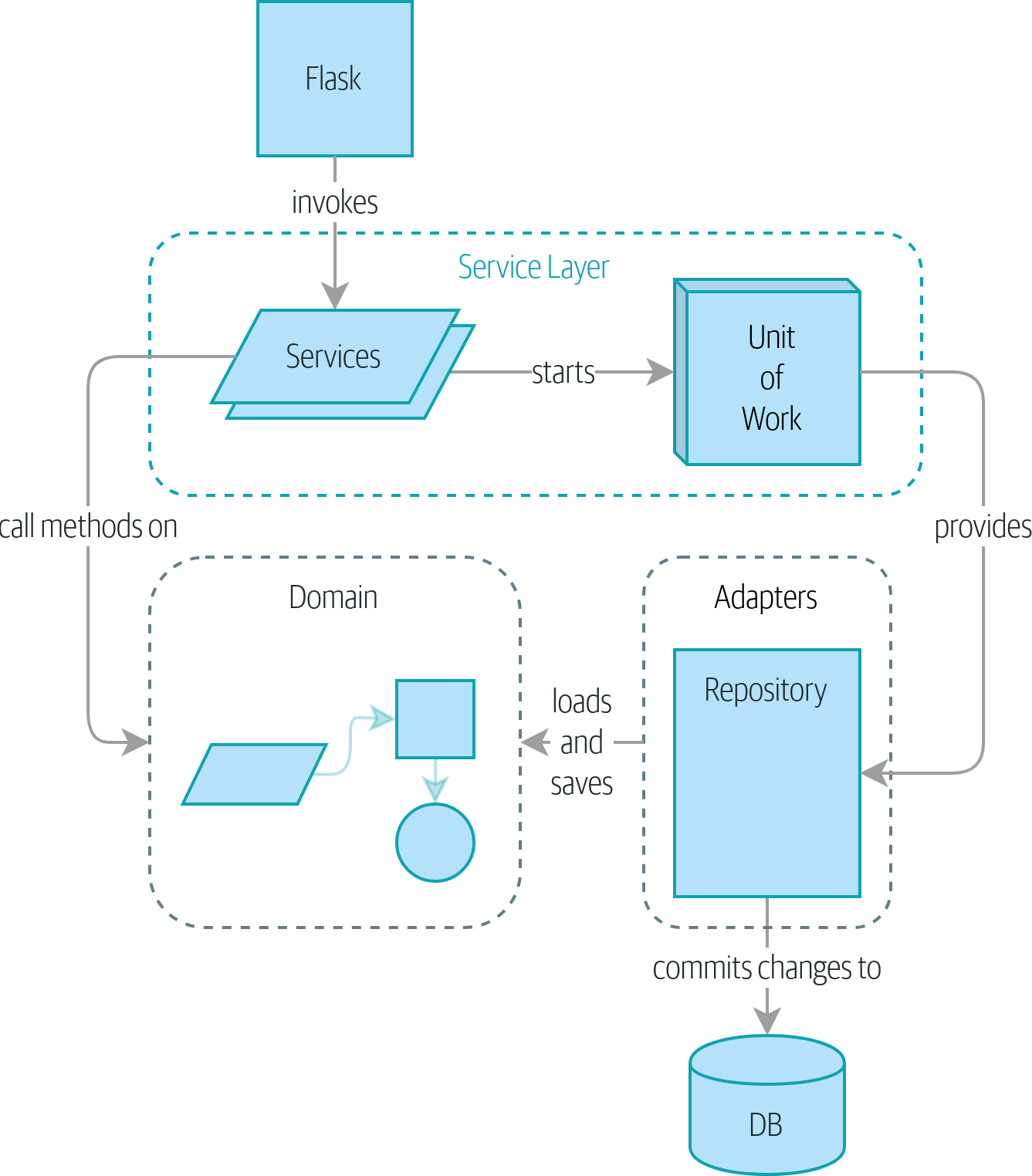

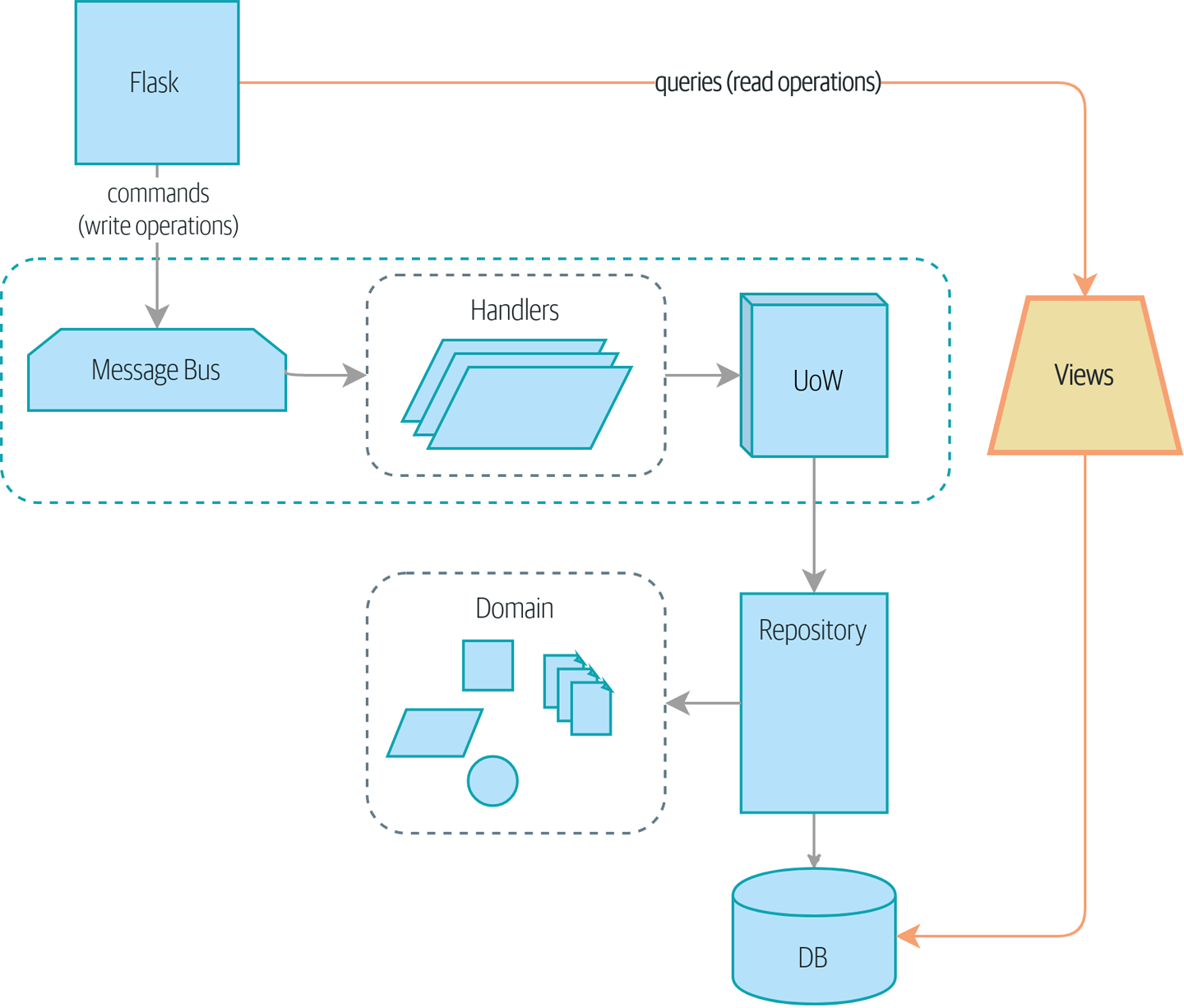

Dans ces trois chapitres, nous présentons trois patterns étroitement liés et mutuellement renforçants qui soutiennent notre ambition de garder le modèle libre de dépendances superflues. Nous construisons une couche d’abstraction autour du stockage persistant, et nous construisons une couche de service pour définir les points d’entrée de notre système et capturer les cas d’usage principaux. Nous montrons comment cette couche facilite la construction de points d’entrée fins à notre système, que ce soit une API Flask ou un CLI.

- Quelques réflexions sur les tests et les abstractions (Chapitre 3 et 5)

-

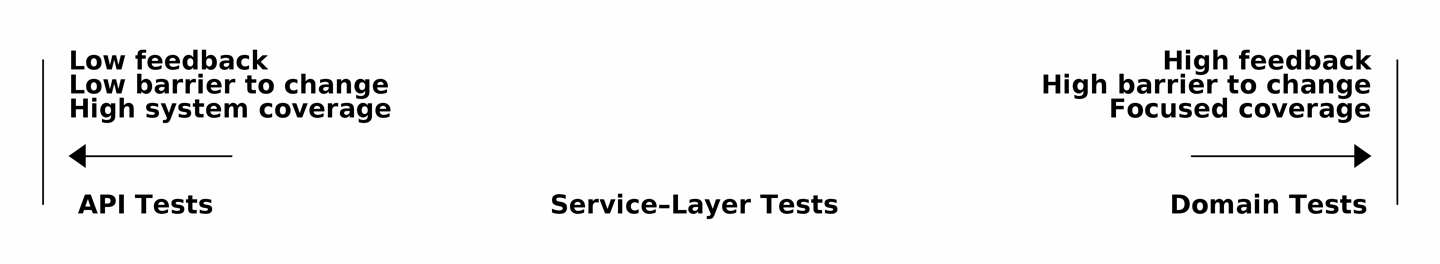

Après avoir présenté la première abstraction (le pattern Dépôt - Repository), nous saisissons l’opportunité d’une discussion générale sur comment choisir les abstractions, et quel est leur rôle dans le choix de la manière dont notre logiciel est couplé. Après avoir introduit le pattern Couche de Service (Service Layer), nous parlons un peu d’atteindre une pyramide de tests et d’écrire des tests unitaires au niveau d’abstraction le plus élevé possible.

#part2

- Architecture événementielle (Chapitres 8-11)

-

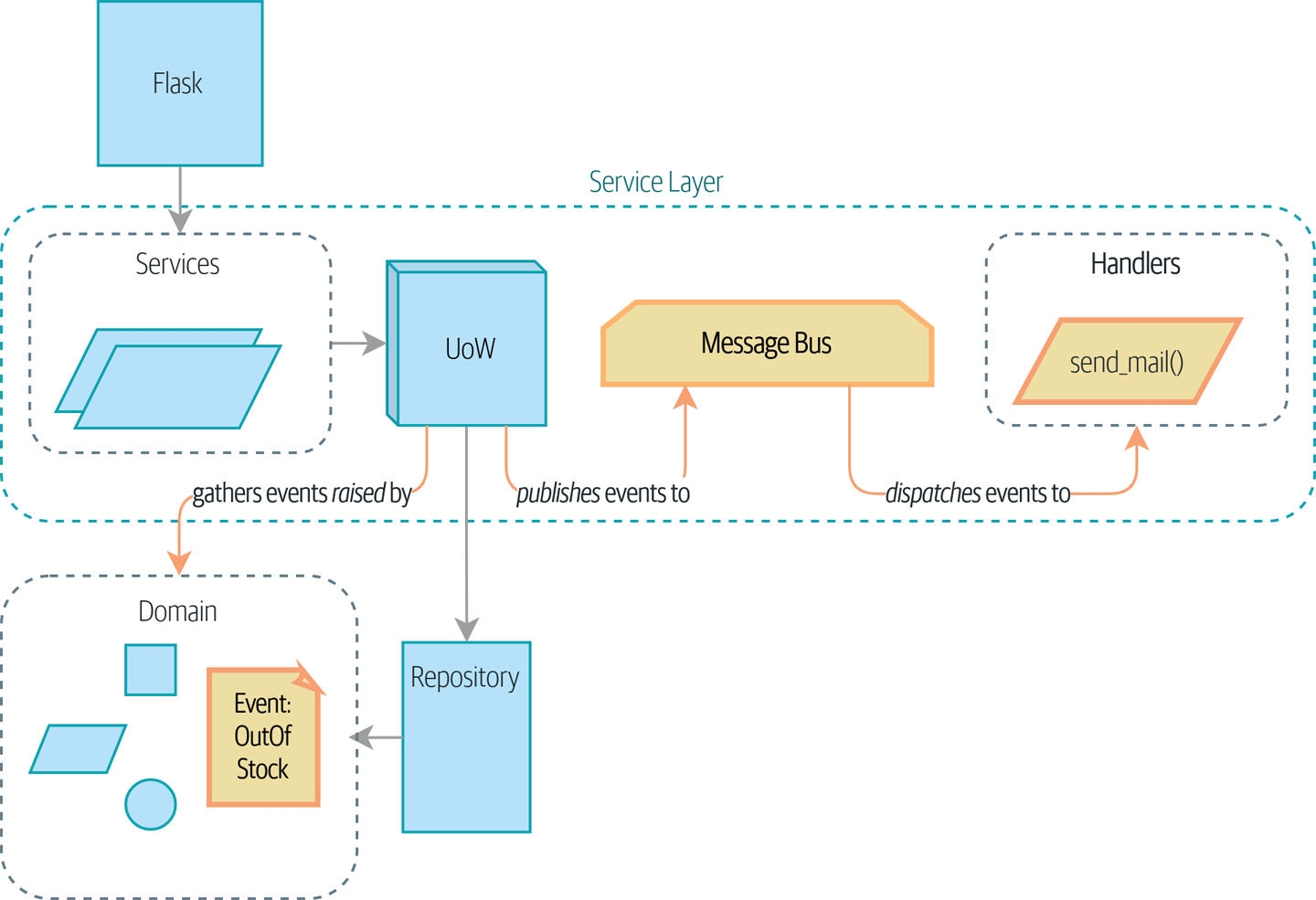

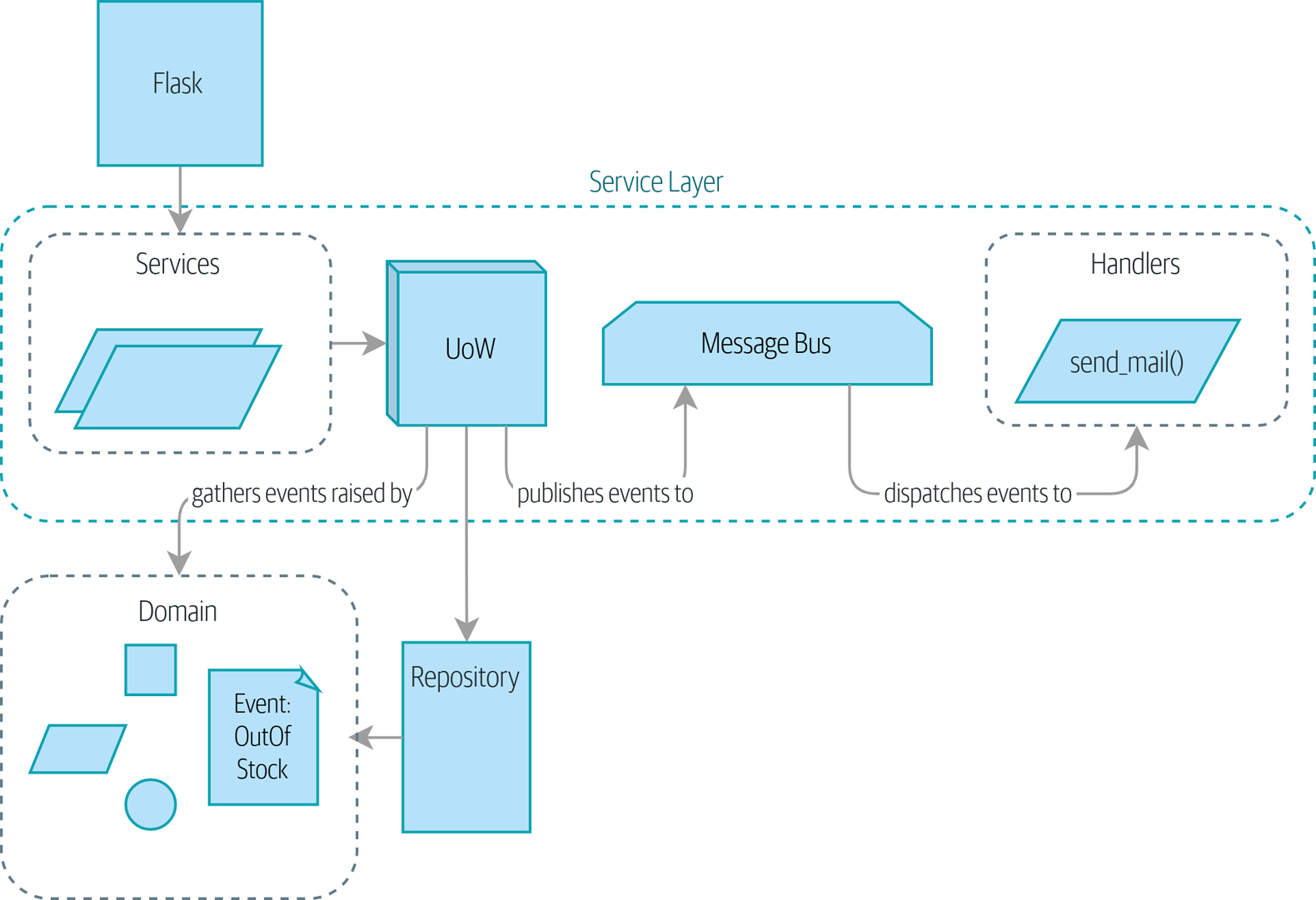

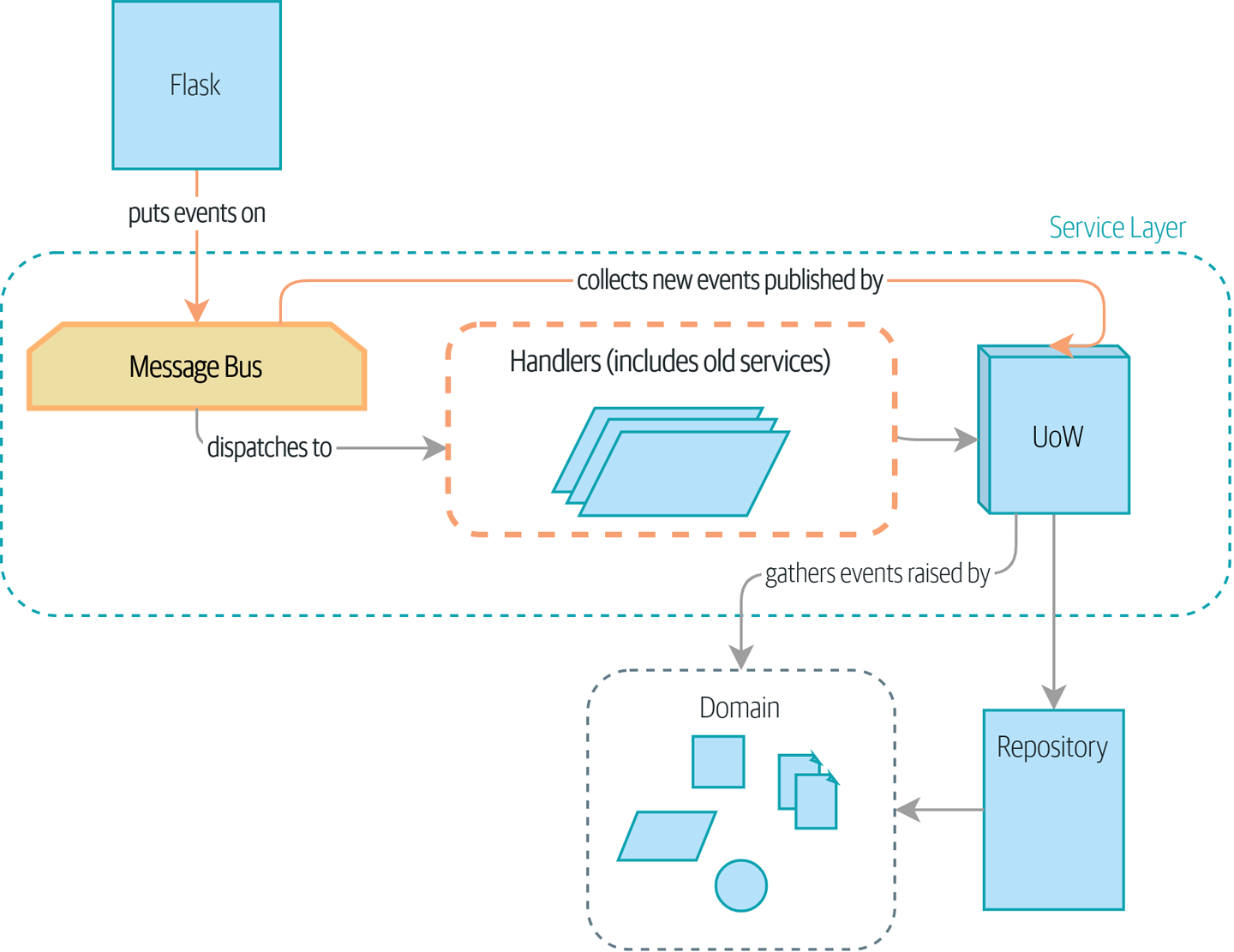

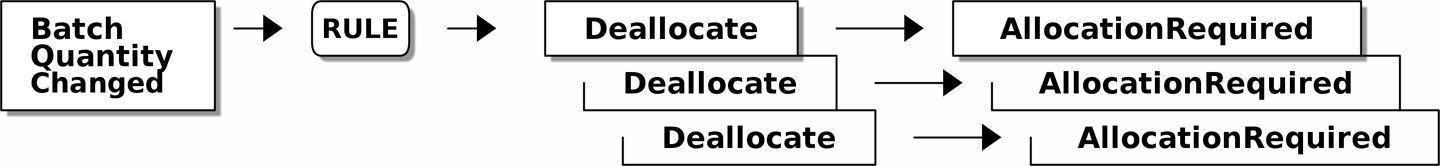

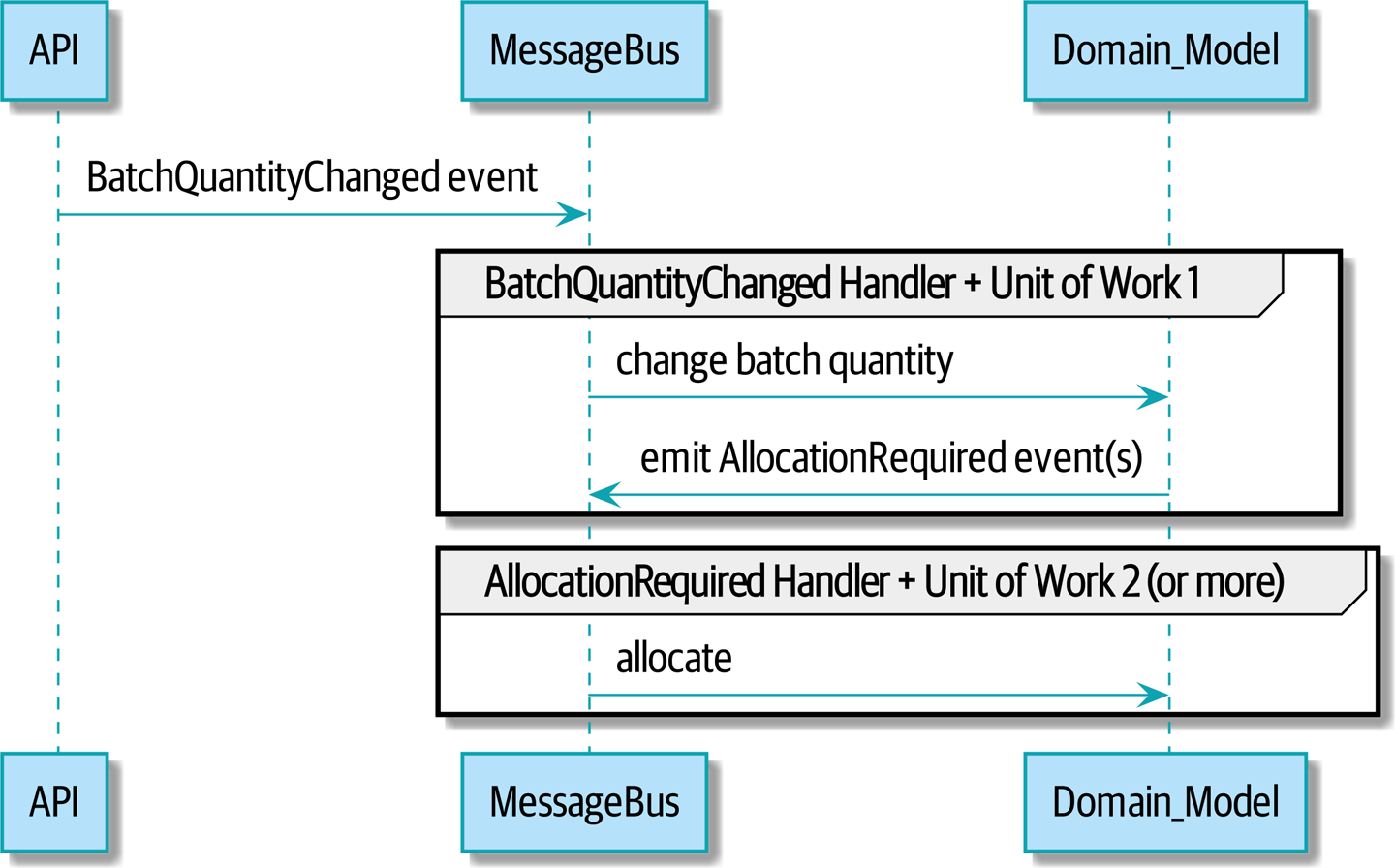

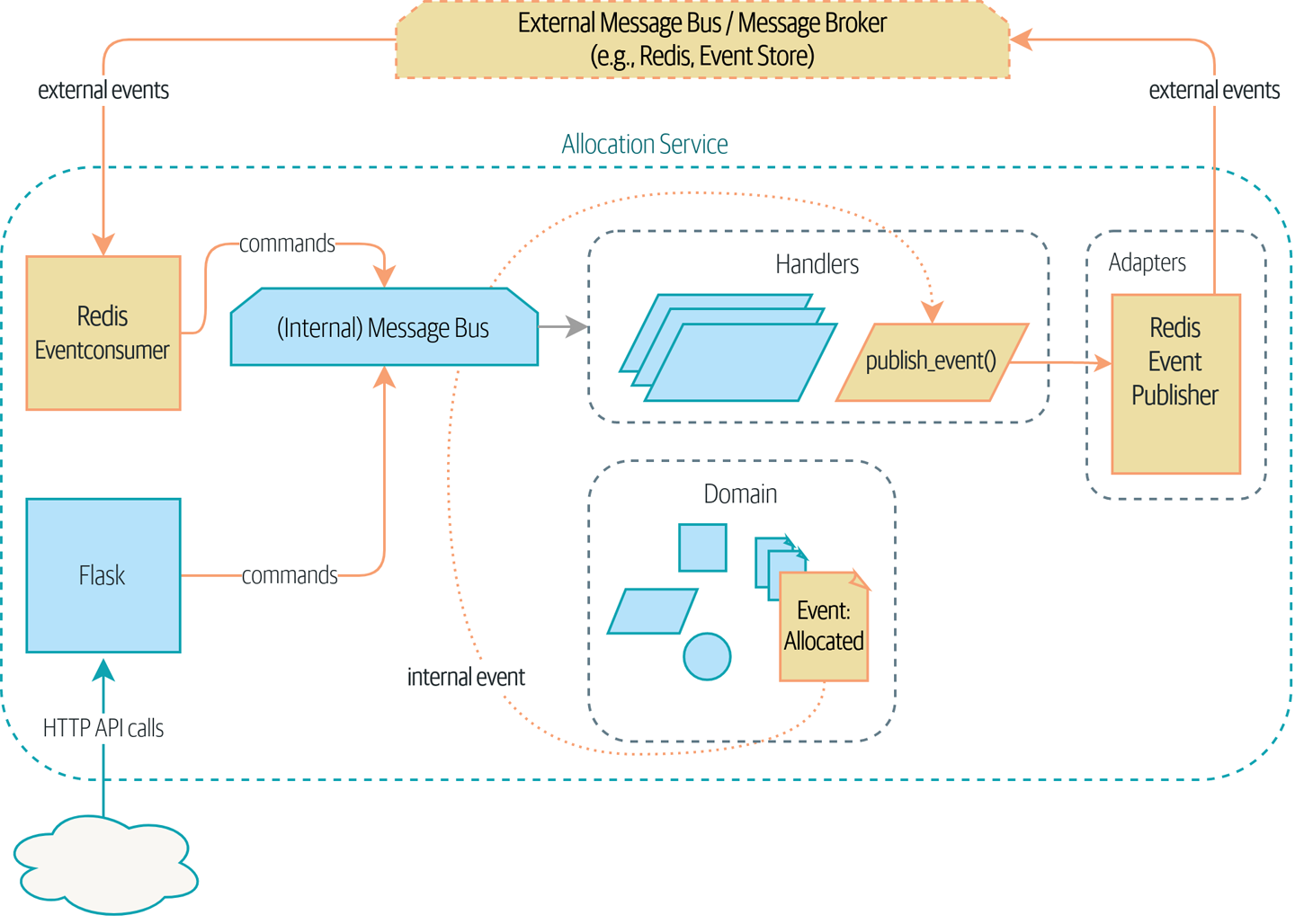

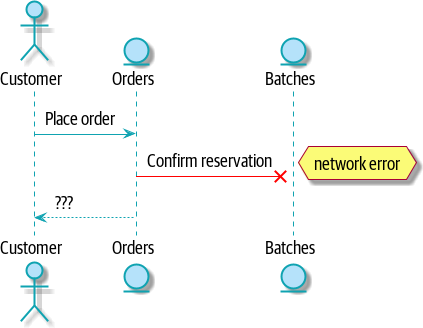

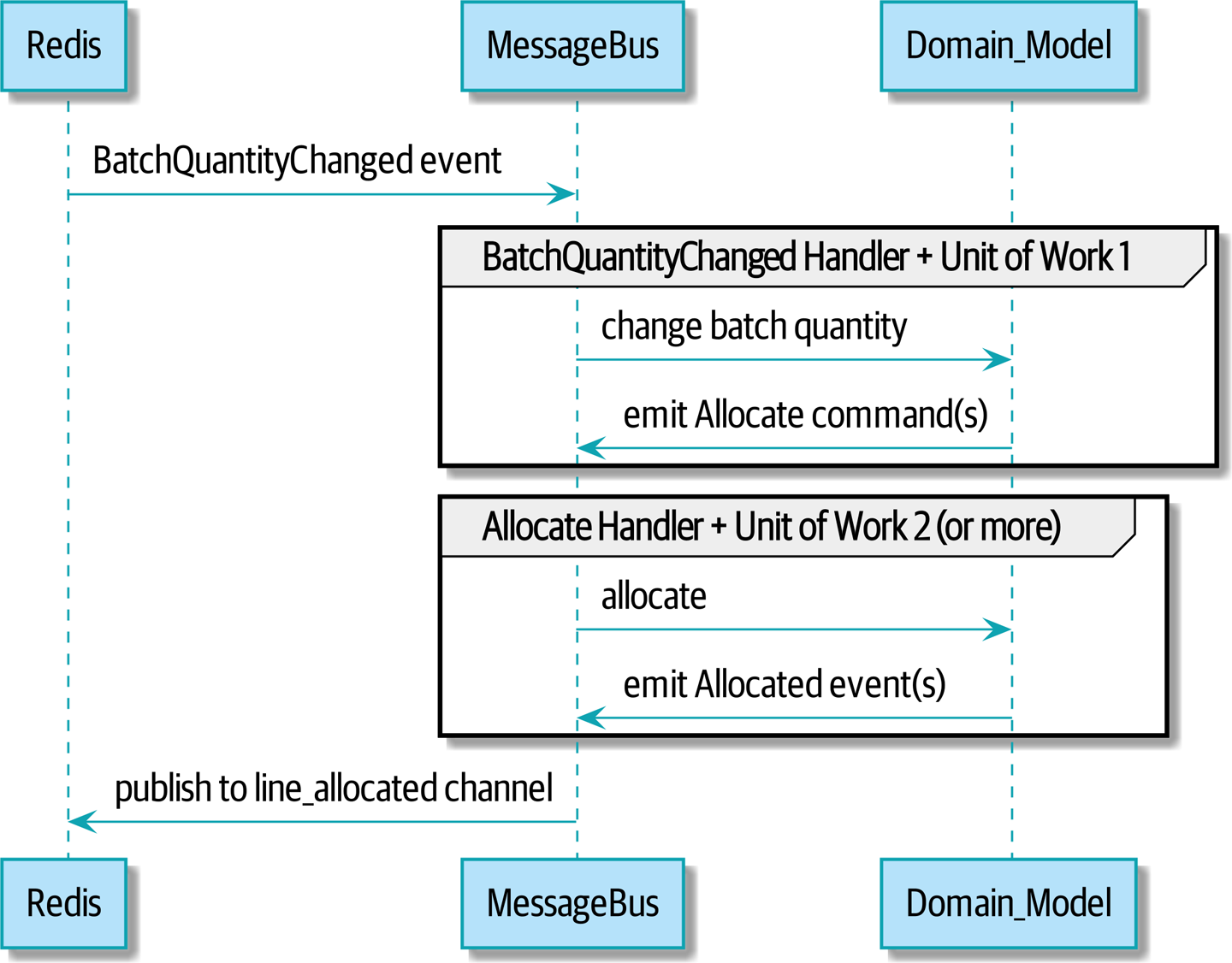

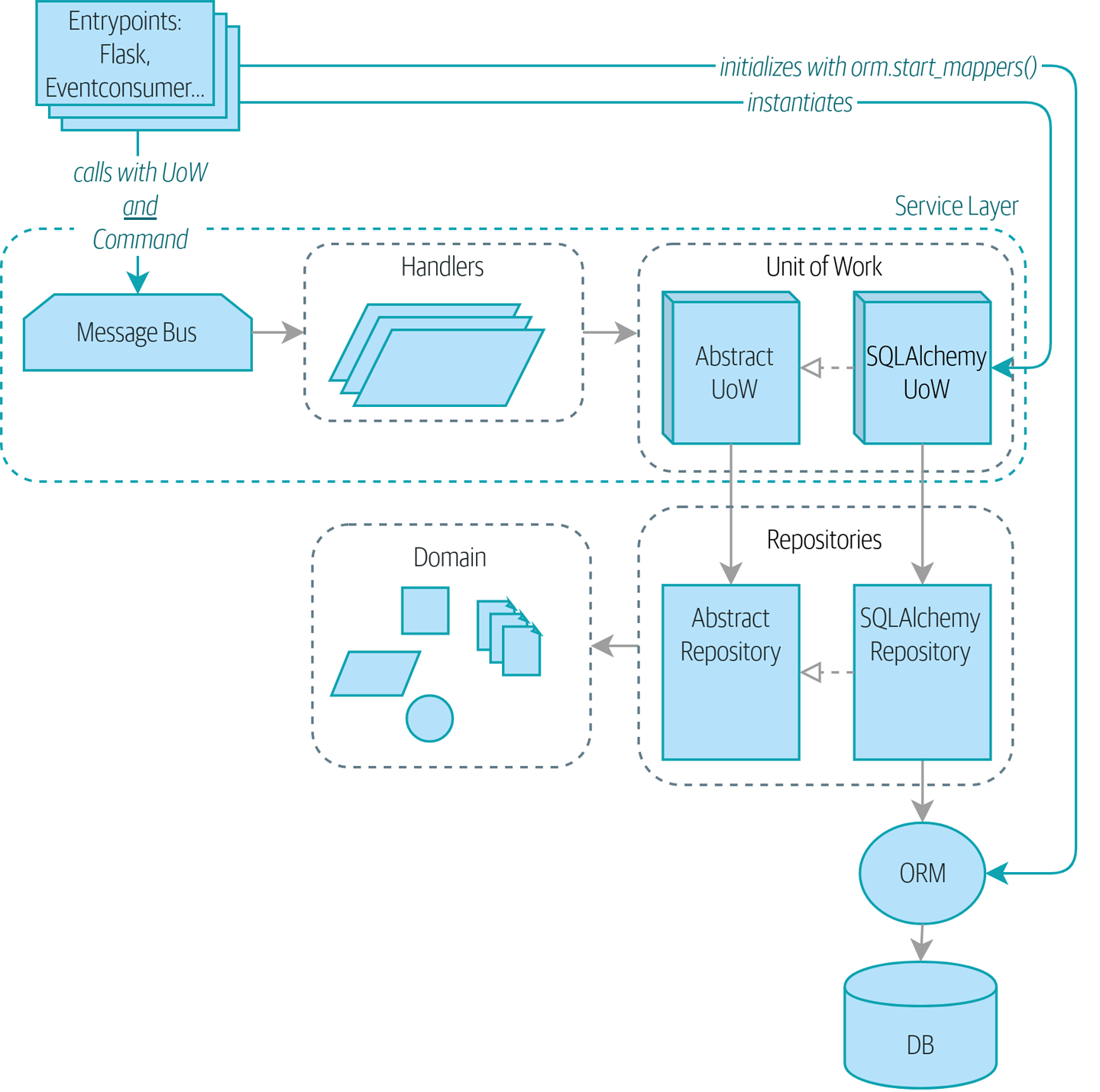

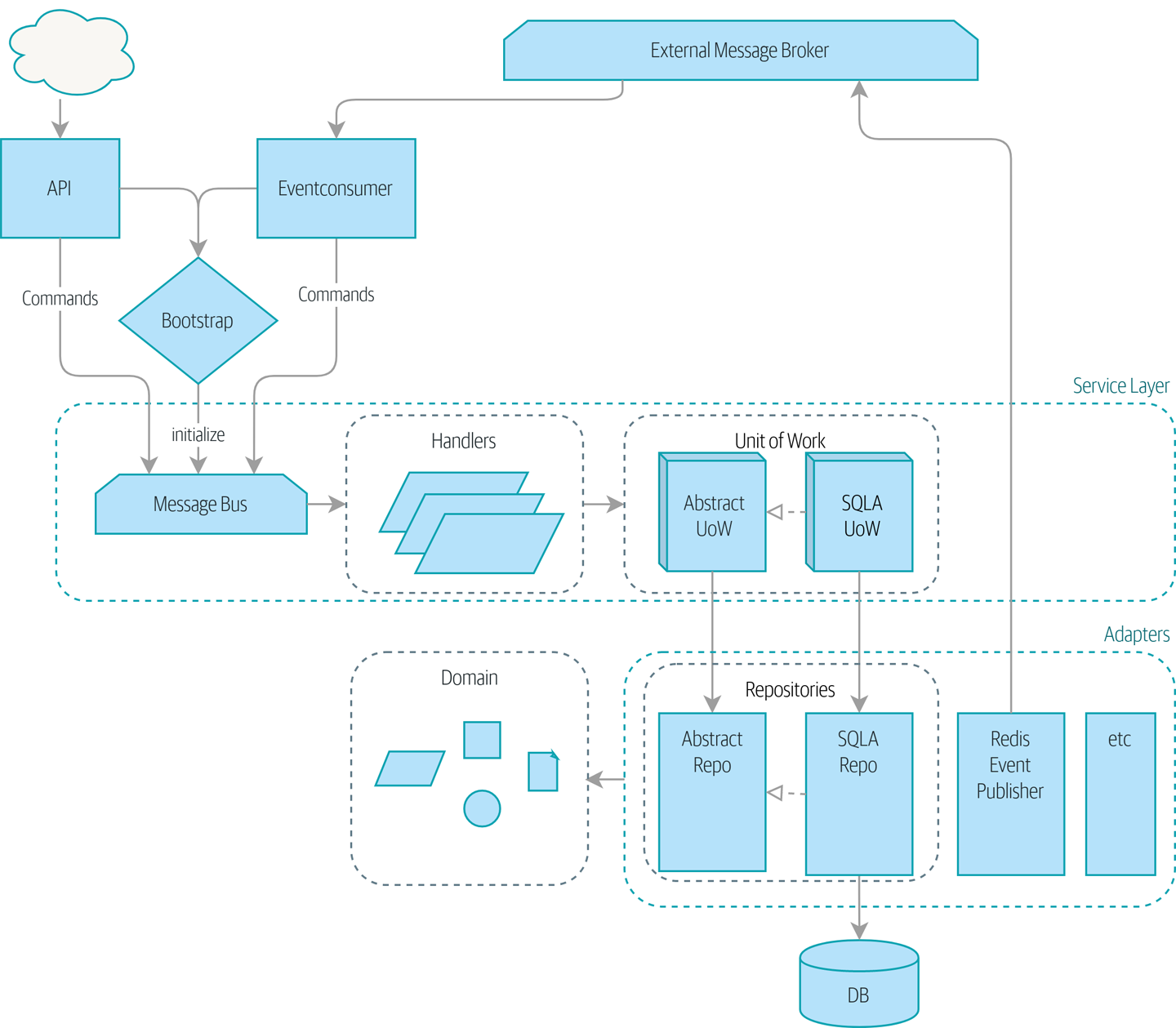

Nous introduisons trois patterns supplémentaires mutuellement renforçants : les patterns Événements de Domaine (Domain Events), Bus de Messages (Message Bus), et Gestionnaire (Handler). Les événements de domaine sont un véhicule pour capturer l’idée que certaines interactions avec un système sont des déclencheurs pour d’autres. Nous utilisons un bus de messages pour permettre aux actions de déclencher des événements et d’appeler les gestionnaires appropriés. Nous poursuivons en discutant comment les événements peuvent être utilisés comme un pattern d’intégration entre services dans une architecture de microservices. Enfin, nous distinguons entre commandes et événements. Notre application est maintenant fondamentalement un système de traitement de messages.

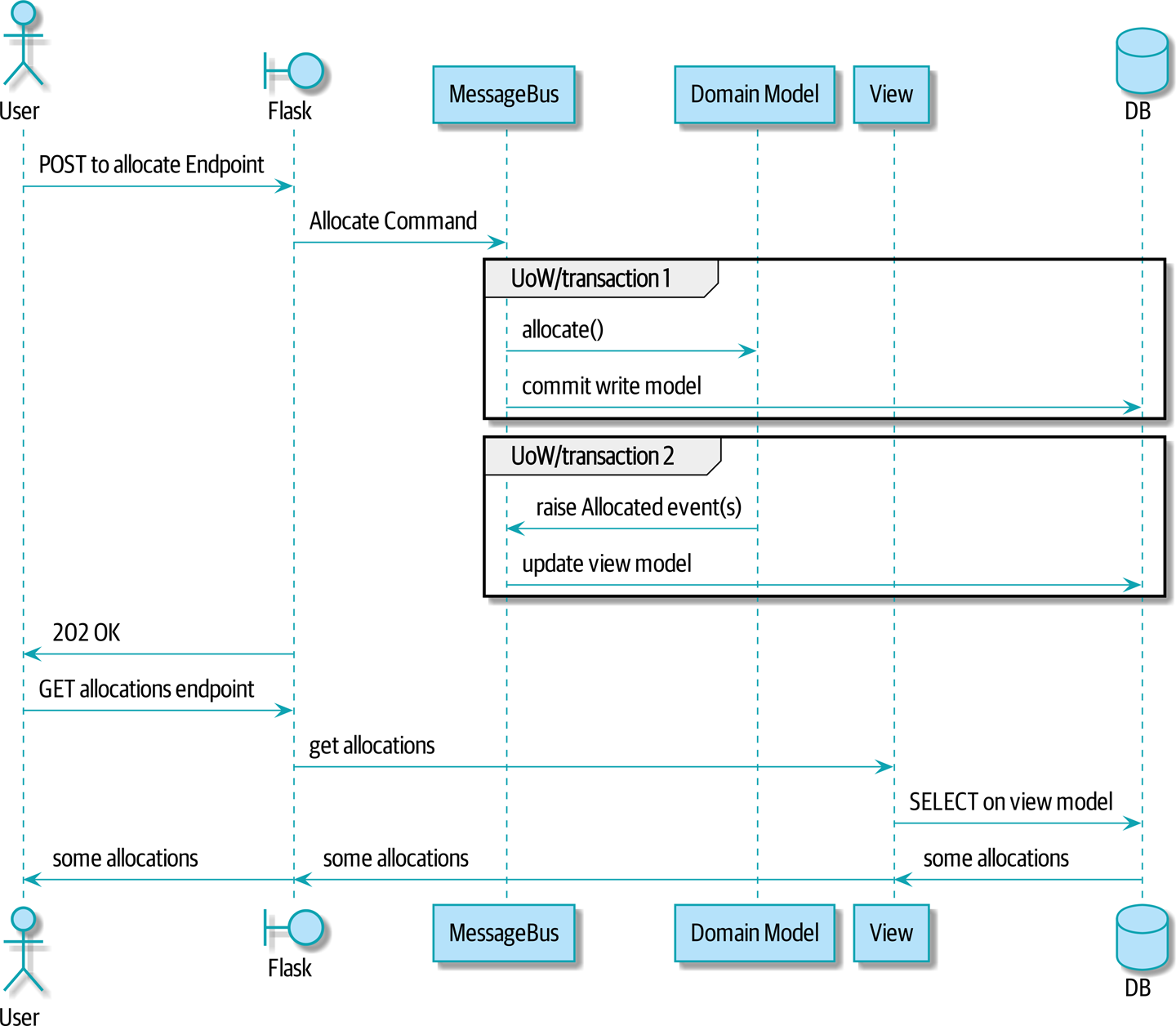

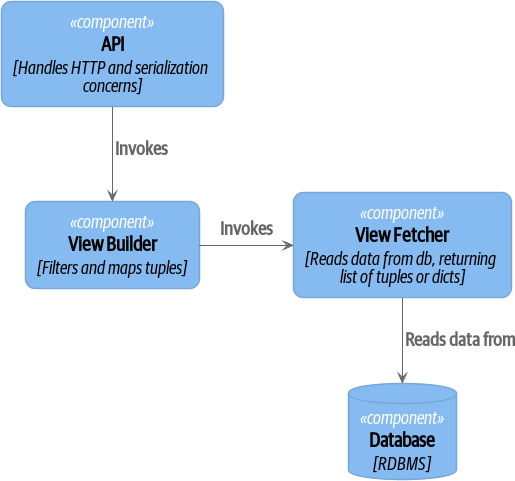

- Ségrégation des responsabilités commande-requête (CQRS (Command Query Responsibility Segregation/Ségrégation des Responsabilités Commande-Requête))

-

Nous présentons un exemple de ségrégation des responsabilités commande-requête (command-query responsibility segregation), avec et sans événements.

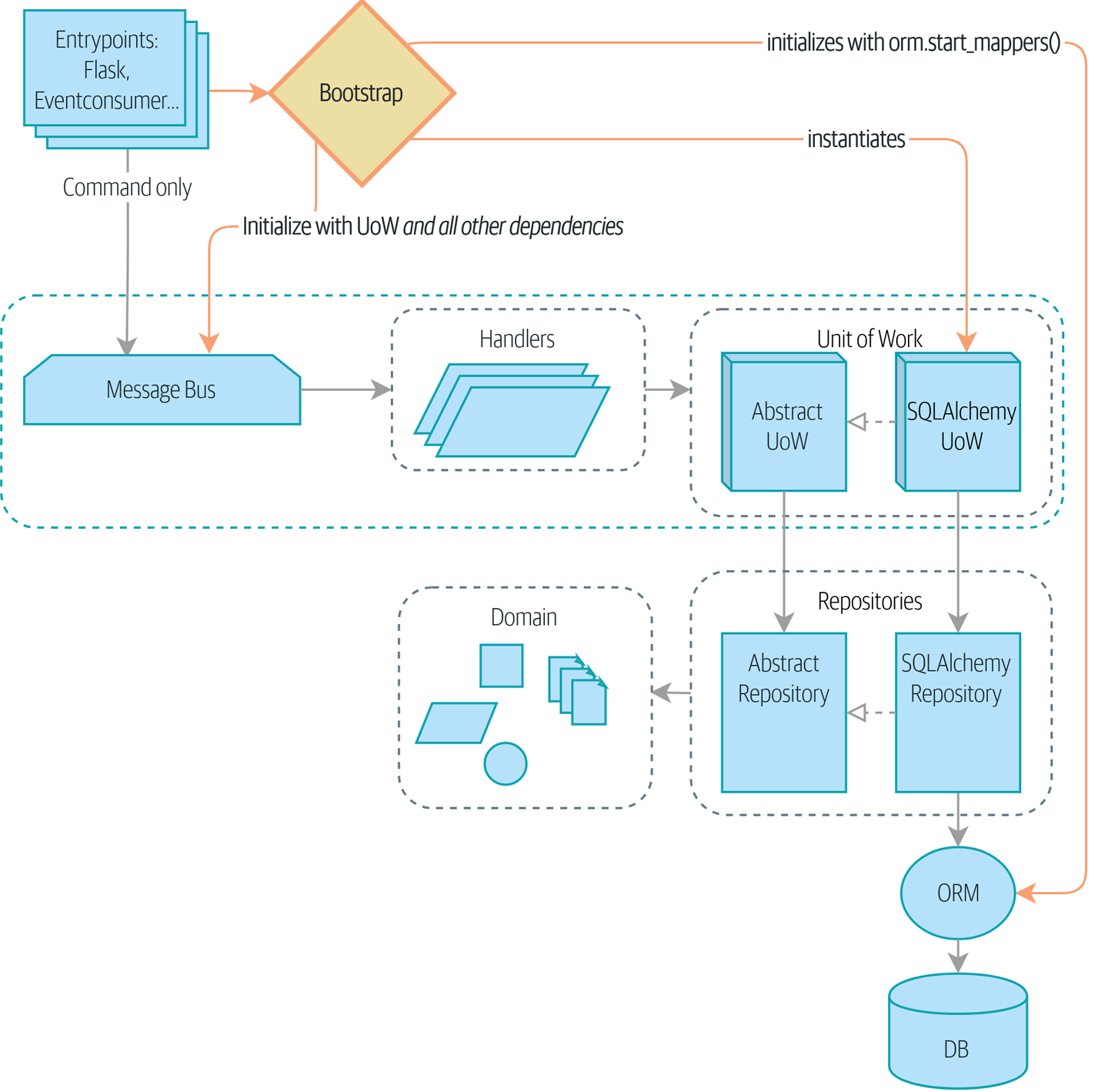

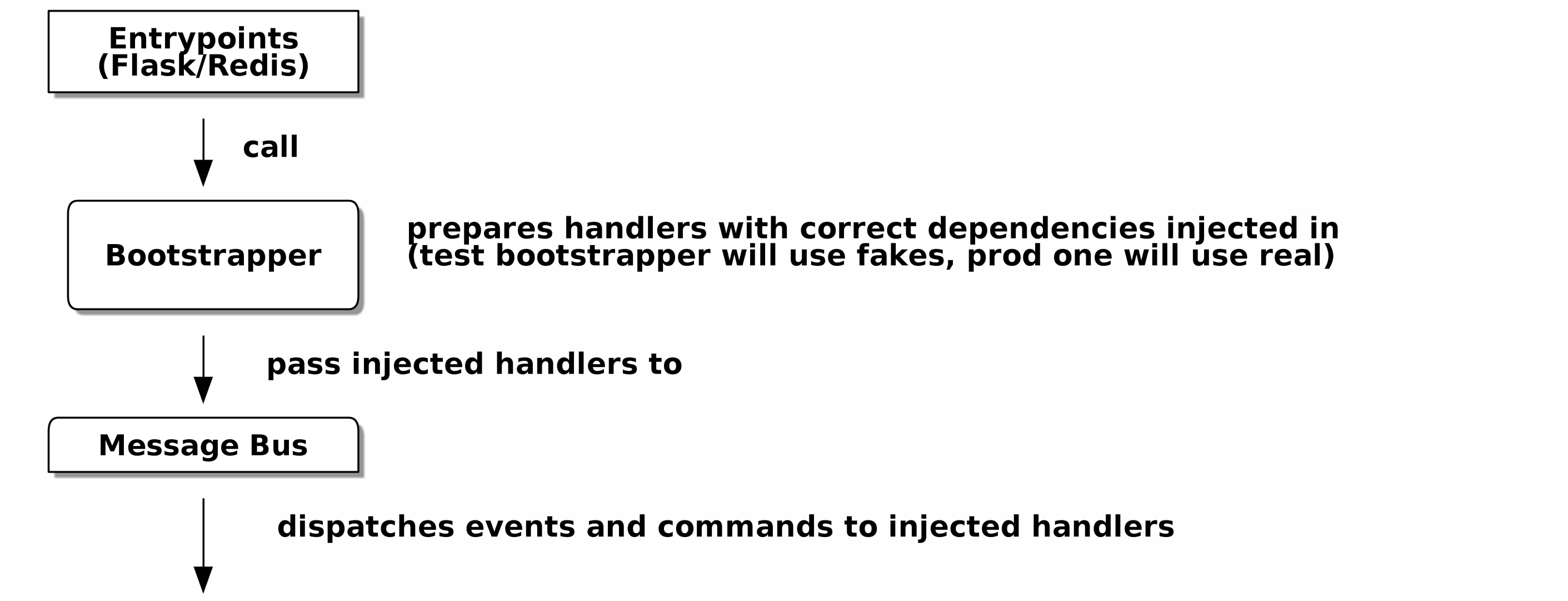

- Injection de dépendances (Injection de Dépendances (Dependency Injection) (et Amorçage))

-

Nous rangeons nos dépendances explicites et implicites et implémentons un simple framework d’injection de dépendances.

Contenu Additionnel

- Comment y arriver à partir d’ici ? (Épilogue)

-

Implémenter des patterns architecturaux semble toujours facile lorsque vous montrez un exemple simple, en partant de zéro, mais beaucoup d’entre vous se demanderont probablement comment appliquer ces principes aux logiciels existants. Nous fournirons quelques pointeurs dans l’épilogue et quelques liens vers des lectures complémentaires.

Exemple de Code et Coder en Suivant

Vous lisez un livre, mais vous serez probablement d’accord avec nous lorsque nous disons que la meilleure façon d’apprendre sur le code est de coder. Nous avons appris la majeure partie de ce que nous savons en faisant du pair programming avec des gens, en écrivant du code avec eux, et en apprenant en faisant, et nous aimerions recréer cette expérience autant que possible pour vous dans ce livre.

En conséquence, nous avons structuré le livre autour d’un seul projet d’exemple (bien que nous lancions parfois d’autres exemples). Nous construirons ce projet au fur et à mesure de la progression des chapitres, comme si vous aviez fait du pair programming avec nous et que nous expliquions ce que nous faisons et pourquoi à chaque étape.

Mais pour vraiment saisir ces patterns, vous devez manipuler le code et avoir une idée de comment il fonctionne. Vous trouverez tout le code sur GitHub ; chaque chapitre a sa propre branche. Vous pouvez trouver une liste des branches sur GitHub également.

Voici trois façons dont vous pourriez coder en suivant le livre :

-

Démarrer votre propre dépôt et essayer de construire l’application comme nous le faisons, en suivant les exemples des listings du livre, et en regardant occasionnellement notre dépôt pour des indices. Un avertissement cependant : si vous avez lu le livre précédent de Harry et codé en suivant, vous constaterez que ce livre vous demande de comprendre davantage par vous-même ; vous devrez peut-être vous appuyer assez lourdement sur les versions fonctionnelles sur GitHub.

-

Essayer d’appliquer chaque pattern, chapitre par chapitre, à votre propre projet (de préférence petit/jouet), et voir si vous pouvez le faire fonctionner pour votre cas d’usage. C’est à haut risque/haute récompense (et beaucoup d’efforts en plus !). Cela peut prendre pas mal de travail pour faire fonctionner les choses pour les spécificités de votre projet, mais d’un autre côté, vous êtes susceptible d’apprendre le plus.

-

Pour moins d’effort, dans chaque chapitre nous décrivons un "Exercice pour le Lecteur," et vous pointons vers un emplacement GitHub où vous pouvez télécharger du code partiellement terminé pour le chapitre avec quelques parties manquantes à écrire vous-même.

Particulièrement si vous avez l’intention d’appliquer certains de ces patterns dans vos propres projets, travailler sur un exemple simple est un excellent moyen de pratiquer en toute sécurité.

Au strict minimum, faites un git checkout du code depuis notre dépôt pendant que vous

lisez chaque chapitre. Pouvoir plonger et voir le code dans le contexte d’une

application réellement fonctionnelle aidera à répondre à beaucoup de questions au fur et à mesure, et

rend tout plus réel. Vous trouverez des instructions sur comment faire cela

au début de chaque chapitre.

|

Licence

Le code (et la version en ligne du livre) est sous licence Creative Commons CC BY-NC-ND, ce qui signifie que vous êtes libre de le copier et de le partager avec qui vous voulez, à des fins non commerciales, tant que vous donnez l’attribution. Si vous voulez réutiliser une partie du contenu de ce livre et que vous avez des inquiétudes concernant la licence, contactez O’Reilly à permissions@oreilly.com.

L’édition imprimée est sous une licence différente ; veuillez consulter la page de copyright.

Conventions Utilisées dans Ce Livre

Les conventions typographiques suivantes sont utilisées dans ce livre :

- Italique

-

Indique de nouveaux termes, URL, adresses email, noms de fichiers et extensions de fichiers.

- Largeur constante

-

Utilisé pour les listings de programme, ainsi qu’à l’intérieur des paragraphes pour faire référence à des éléments de programme tels que des noms de variables ou de fonctions, bases de données, types de données, variables d’environnement, instructions et mots-clés.

Largeur constante gras-

Montre les commandes ou autre texte qui devrait être tapé littéralement par l’utilisateur.

- Largeur constante italique

-

Montre le texte qui devrait être remplacé par des valeurs fournies par l’utilisateur ou par des valeurs déterminées par le contexte.

|

Cet élément signifie un conseil ou une suggestion. |

|

Cet élément signifie une note générale. |

|

Cet élément indique un avertissement ou une mise en garde. |

O’Reilly Online Learning

|

Depuis plus de 40 ans, O'Reilly Media fournit des formations technologiques et commerciales, des connaissances et des insights pour aider les entreprises à réussir. |

Notre réseau unique d’experts et d’innovateurs partagent leurs connaissances et leur expertise à travers des livres, des articles, des conférences et notre plateforme d’apprentissage en ligne. La plateforme d’apprentissage en ligne d’O’Reilly vous donne un accès à la demande à des cours de formation en direct, des parcours d’apprentissage approfondis, des environnements de codage interactifs, et une vaste collection de textes et vidéos d’O’Reilly et de plus de 200 autres éditeurs. Pour plus d’informations, veuillez visiter http://oreilly.com.

Comment Contacter O’Reilly

Veuillez adresser les commentaires et questions concernant ce livre à l’éditeur :

- O'Reilly Media, Inc.

- 1005 Gravenstein Highway North

- Sebastopol, CA 95472

- 800-998-9938 (aux États-Unis ou au Canada)

- 707-829-0515 (international ou local)

- 707-829-0104 (fax)

Nous avons une page web pour ce livre, où nous listons les errata, exemples et toute information additionnelle. Vous pouvez accéder à cette page à https://oreil.ly/architecture-patterns-python.

Envoyez un email à bookquestions@oreilly.com pour commenter ou poser des questions techniques sur ce livre.

Pour plus d’informations sur nos livres, cours, conférences et actualités, consultez notre site web à http://www.oreilly.com.

Trouvez-nous sur Facebook : http://facebook.com/oreilly

Suivez-nous sur Twitter : http://twitter.com/oreillymedia

Regardez-nous sur YouTube : http://www.youtube.com/oreillymedia

Remerciements

À nos relecteurs techniques, David Seddon, Ed Jung, et Hynek Schlawack : nous ne vous méritons absolument pas. Vous êtes tous incroyablement dévoués, consciencieux, et rigoureux. Chacun de vous est immensément intelligent, et vos différents points de vue ont été à la fois utiles et complémentaires les uns aux autres. Merci du fond de nos cœurs.

Gigantesques remerciements également à tous nos lecteurs jusqu’à présent pour leurs commentaires et suggestions : Ian Cooper, Abdullah Ariff, Jonathan Meier, Gil Gonçalves, Matthieu Choplin, Ben Judson, James Gregory, Łukasz Lechowicz, Clinton Roy, Vitorino Araújo, Susan Goodbody, Josh Harwood, Daniel Butler, Liu Haibin, Jimmy Davies, Ignacio Vergara Kausel, Gaia Canestrani, Renne Rocha, pedroabi, Ashia Zawaduk, Jostein Leira, Brandon Rhodes, Jazeps Basko, simkimsia, Adrien Brunet, Sergey Nosko, et bien d’autres ; nos excuses si nous vous avons oublié sur cette liste.

Super-méga-merci à notre éditeur Corbin Collins pour ses encouragements gentils, et pour être un défenseur infatigable du lecteur. Remerciements tout aussi superlatifs au personnel de production, Katherine Tozer, Sharon Wilkey, Ellen Troutman-Zaig, et Rebecca Demarest, pour votre dévouement, professionnalisme, et attention au détail. Ce livre est incommensurablement amélioré grâce à vous.

Toutes erreurs restant dans le livre sont les nôtres, naturellement.

Introduction

Pourquoi Nos Conceptions Tournent-elles Mal ?

Qu’est-ce qui vous vient à l’esprit lorsque vous entendez le mot chaos ? Peut-être pensez-vous à une bourse bruyante, ou à votre cuisine le matin — tout est confus et en désordre. Lorsque vous pensez au mot ordre, peut-être imaginez-vous une pièce vide, sereine et calme. Pour les scientifiques, cependant, le chaos est caractérisé par l’homogénéité (uniformité), et l’ordre par la complexité (différence).

Par exemple, un jardin bien entretenu est un système hautement ordonné. Les jardiniers définissent des limites avec des chemins et des clôtures, et ils délimitent des plates-bandes ou des potagers. Au fil du temps, le jardin évolue, devenant plus riche et plus dense ; mais sans effort délibéré, le jardin deviendra sauvage. Les mauvaises herbes et les graminées étoufferont les autres plantes, recouvrant les chemins, jusqu’à ce que finalement chaque partie se ressemble à nouveau — sauvage et non gérée.

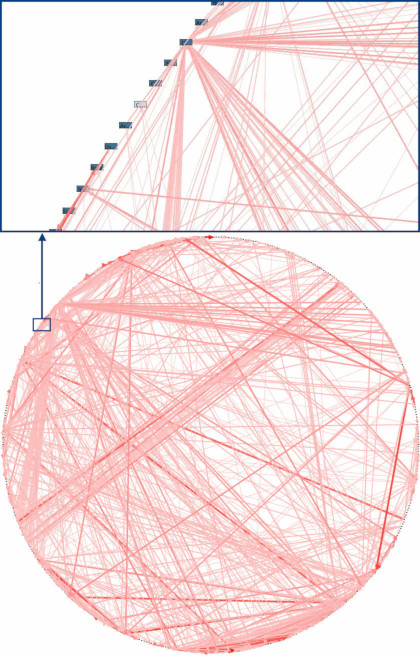

Les systèmes logiciels, eux aussi, tendent vers le chaos. Lorsque nous commençons à construire un nouveau système, nous avons de grandes idées selon lesquelles notre code sera propre et bien ordonné, mais au fil du temps, nous constatons qu’il accumule des scories et des cas particuliers et finit en un fouillis confus de classes gestionnaires et de modules utilitaires. Nous constatons que notre architecture en couches sensée s’est effondrée sur elle-même comme un diplomate trop imbibé. Les systèmes logiciels chaotiques sont caractérisés par une uniformité de fonction : des gestionnaires d’API qui ont des connaissances du domaine et envoient des emails et effectuent de la journalisation ; des classes de "logique métier" qui n’effectuent aucun calcul mais effectuent des E/S ; et tout est couplé à tout le reste de sorte que changer n’importe quelle partie du système devient périlleux. C’est si courant que les ingénieurs logiciels ont leur propre terme pour le chaos : l’anti-pattern Big Ball of Mud (Un diagramme de dépendances réel (source: "Enterprise Dependency: Big Ball of Yarn" par Alex Papadimoulis)).

| Une big ball of mud est l’état naturel du logiciel de la même manière que la nature sauvage est l’état naturel de votre jardin. Il faut de l’énergie et de la direction pour prévenir l’effondrement. |

Heureusement, les techniques pour éviter de créer une big ball of mud ne sont pas complexes.

Encapsulation et Abstractions

L’encapsulation et l’abstraction sont des outils que nous utilisons tous instinctivement en tant que programmeurs, même si nous n’utilisons pas tous ces mots exacts. Permettez-nous de nous y attarder un instant, car ils sont un thème récurrent du livre.

Le terme encapsulation couvre deux idées étroitement liées : simplifier le comportement et cacher les données. Dans cette discussion, nous utilisons le premier sens. Nous encapsulons le comportement en identifiant une tâche qui doit être effectuée dans notre code et en confiant cette tâche à un objet ou une fonction bien défini. Nous appelons cet objet ou cette fonction une abstraction.

Jetez un œil aux deux extraits de code Python suivants :

import json

from urllib.request import urlopen

from urllib.parse import urlencode

params = dict(q='Sausages', format='json')

handle = urlopen('http://api.duckduckgo.com' + '?' + urlencode(params))

raw_text = handle.read().decode('utf8')

parsed = json.loads(raw_text)

results = parsed['RelatedTopics']

for r in results:

if 'Text' in r:

print(r['FirstURL'] + ' - ' + r['Text'])import requests

params = dict(q='Sausages', format='json')

parsed = requests.get('http://api.duckduckgo.com/', params=params).json()

results = parsed['RelatedTopics']

for r in results:

if 'Text' in r:

print(r['FirstURL'] + ' - ' + r['Text'])Les deux listes de code font la même chose : elles soumettent des valeurs encodées sous forme de formulaire à une URL afin d’utiliser une API de moteur de recherche. Mais la seconde est plus simple à lire et à comprendre car elle opère à un niveau d’abstraction plus élevé.

Nous pouvons aller encore plus loin en identifiant et en nommant la tâche que nous voulons que le code effectue pour nous et en utilisant une abstraction de niveau encore plus élevé pour la rendre explicite :

import duckduckpy

for r in duckduckpy.query('Sausages').related_topics:

print(r.first_url, ' - ', r.text)Encapsuler le comportement en utilisant des abstractions est un outil puissant pour rendre le code plus expressif, plus testable et plus facile à maintenir.

| Dans la littérature du monde orienté objet (OO), l’une des caractérisations classiques de cette approche est appelée conception pilotée par les responsabilités ; elle utilise les mots rôles et responsabilités plutôt que tâches. Le point principal est de penser au code en termes de comportement, plutôt qu’en termes de données ou d’algorithmes.[2] |

La plupart des patterns de ce livre impliquent de choisir une abstraction, vous verrez donc de nombreux exemples dans chaque chapitre. De plus, Une Brève Digression : Sur le Couplage et les Abstractions discute spécifiquement de quelques heuristiques générales pour choisir des abstractions.

Stratification en Couches

L’encapsulation et l’abstraction nous aident en cachant les détails et en protégeant la cohérence de nos données, mais nous devons également prêter attention aux interactions entre nos objets et fonctions. Lorsqu’une fonction, un module ou un objet en utilise un autre, nous disons que l’un dépend de l’autre. Ces dépendances forment une sorte de réseau ou de graphe.

Dans une big ball of mud, les dépendances sont hors de contrôle (comme vous l’avez vu dans Un diagramme de dépendances réel (source: "Enterprise Dependency: Big Ball of Yarn" par Alex Papadimoulis)). Modifier un nœud du graphe devient difficile car cela a le potentiel d’affecter de nombreuses autres parties du système. Les architectures en couches sont une façon de s’attaquer à ce problème. Dans une architecture en couches, nous divisons notre code en catégories ou rôles discrets, et nous introduisons des règles sur les catégories de code qui peuvent s’appeler les unes les autres.

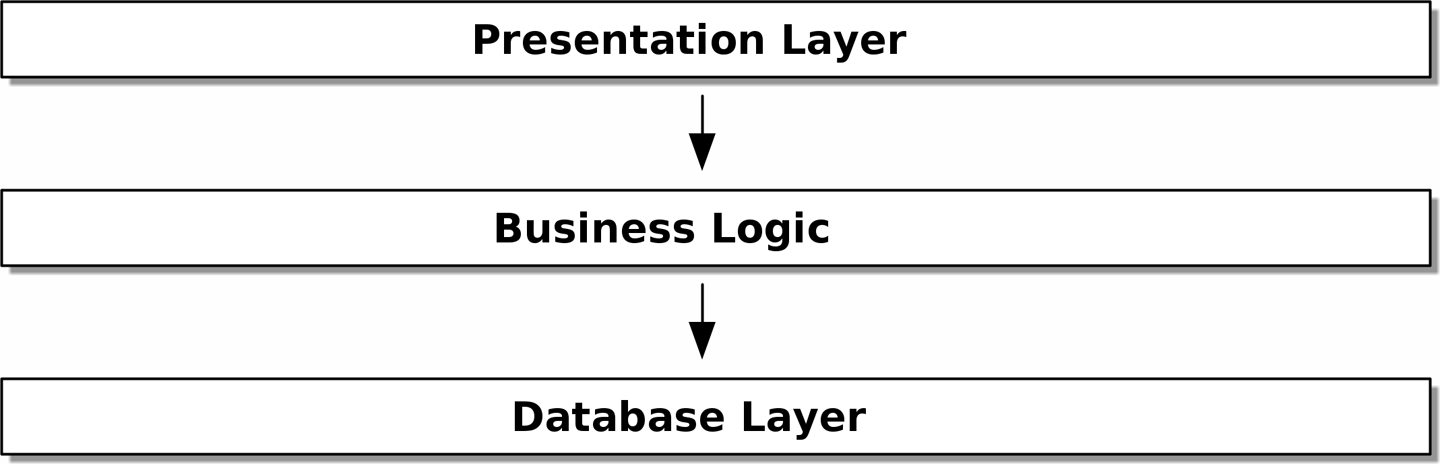

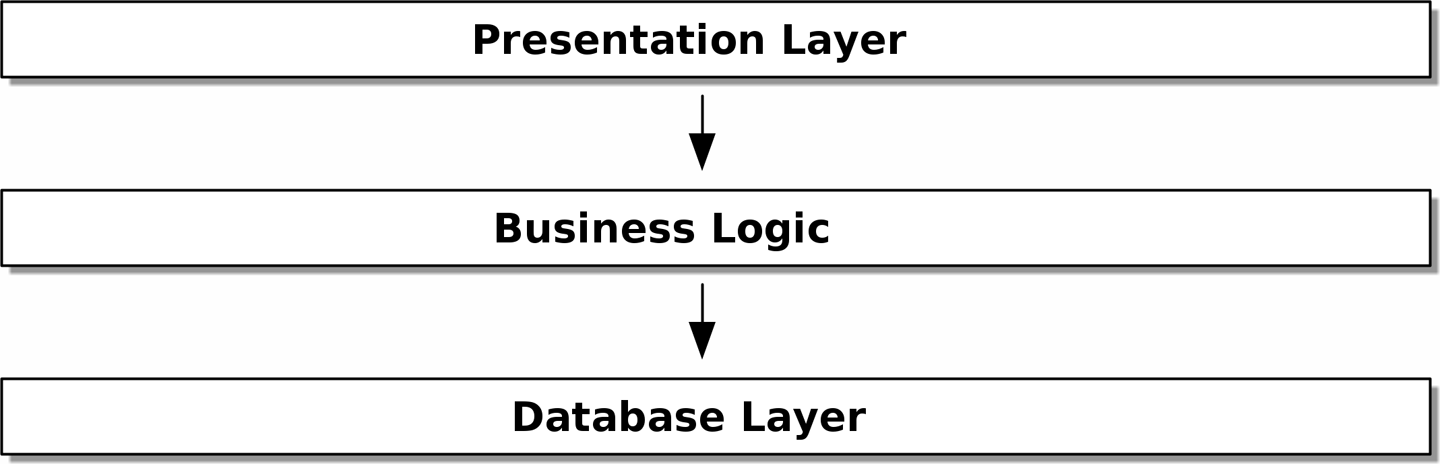

L’un des exemples les plus courants est l'architecture à trois couches illustrée dans Architecture en couches.

[ditaa, apwp_0002]

+----------------------------------------------------+

| Presentation Layer |

+----------------------------------------------------+

|

V

+----------------------------------------------------+

| Business Logic |

+----------------------------------------------------+

|

V

+----------------------------------------------------+

| Database Layer |

+----------------------------------------------------+

L’architecture en couches est peut-être le pattern le plus courant pour construire des logiciels d’entreprise. Dans ce modèle, nous avons des composants d’interface utilisateur, qui peuvent être une page web, une API ou une ligne de commande ; ces composants d’interface utilisateur communiquent avec une couche de logique métier qui contient nos règles métier et nos flux de travail ; et enfin, nous avons une couche de base de données qui est responsable du stockage et de la récupération des données.

Pour le reste de ce livre, nous allons systématiquement retourner ce modèle en obéissant à un principe simple.

Le Principe d’Inversion de Dépendance

Vous connaissez peut-être déjà le principe d’inversion de dépendance (Dependency Inversion Principle, DIP), car c’est le D de SOLID.[3]

Malheureusement, nous ne pouvons pas illustrer le DIP en utilisant trois petites listes de code comme nous l’avons fait pour l’encapsulation. Cependant, l’ensemble de la Construire une Architecture pour Supporter la Modélisation de Domaine est essentiellement un exemple détaillé d’implémentation du DIP dans une application, vous aurez donc votre dose d’exemples concrets.

En attendant, nous pouvons parler de la définition formelle du DIP :

-

Les modules de haut niveau ne devraient pas dépendre des modules de bas niveau. Les deux devraient dépendre d’abstractions.

-

Les abstractions ne devraient pas dépendre des détails. Au contraire, les détails devraient dépendre des abstractions.

Mais qu’est-ce que cela signifie ? Prenons-le morceau par morceau.

Les modules de haut niveau sont le code qui intéresse vraiment votre organisation. Peut-être travaillez-vous pour une société pharmaceutique, et vos modules de haut niveau traitent des patients et des essais. Peut-être travaillez-vous pour une banque, et vos modules de haut niveau gèrent des transactions et des échanges. Les modules de haut niveau d’un système logiciel sont les fonctions, classes et packages qui traitent de nos concepts du monde réel.

Par contraste, les modules de bas niveau sont le code qui n’intéresse pas votre organisation. Il est peu probable que votre département des ressources humaines soit enthousiaste à propos des systèmes de fichiers ou des sockets réseau. Ce n’est pas souvent que vous discutez de SMTP, HTTP ou AMQP avec votre équipe financière. Pour nos parties prenantes non techniques, ces concepts de bas niveau ne sont ni intéressants ni pertinents. Tout ce qui les intéresse, c’est de savoir si les concepts de haut niveau fonctionnent correctement. Si la paie fonctionne à temps, votre entreprise ne se soucie probablement pas de savoir s’il s’agit d’une tâche cron ou d’une fonction transitoire s’exécutant sur Kubernetes.

Dépend de ne signifie pas nécessairement importe ou appelle, mais plutôt une idée plus générale qu’un module connaît ou a besoin d’un autre module.

Et nous avons déjà mentionné les abstractions : ce sont des interfaces simplifiées qui encapsulent le comportement, de la façon dont notre module duckduckgo encapsulait l’API d’un moteur de recherche.

Tous les problèmes en informatique peuvent être résolus en ajoutant un autre niveau d’indirection.

Ainsi, la première partie du DIP dit que notre code métier ne devrait pas dépendre de détails techniques ; au lieu de cela, les deux devraient utiliser des abstractions.

Pourquoi ? Globalement, parce que nous voulons pouvoir les changer indépendamment l’un de l’autre. Les modules de haut niveau devraient être faciles à changer en réponse aux besoins métier. Les modules de bas niveau (détails) sont souvent, en pratique, plus difficiles à changer : pensez au refactoring pour changer un nom de fonction versus définir, tester et déployer une migration de base de données pour changer un nom de colonne. Nous ne voulons pas que les changements de logique métier ralentissent parce qu’ils sont étroitement couplés aux détails d’infrastructure de bas niveau. Mais, de même, il est important de pouvoir changer vos détails d’infrastructure quand vous en avez besoin (pensez au sharding d’une base de données, par exemple), sans avoir besoin d’apporter des modifications à votre couche métier. Ajouter une abstraction entre eux (le fameux niveau supplémentaire d’indirection) permet aux deux de changer (plus) indépendamment l’un de l’autre.

La deuxième partie est encore plus mystérieuse. "Les abstractions ne devraient pas dépendre des détails" semble assez clair, mais "Les détails devraient dépendre des abstractions" est difficile à imaginer. Comment pouvons-nous avoir une abstraction qui ne dépend pas des détails qu’elle abstrait ? Au moment où nous arrivons au Notre Premier Cas d’Usage (Use Case) : API Flask et Couche de Service (Service Layer), nous aurons un exemple concret qui devrait rendre tout cela un peu plus clair.

Un Endroit pour Toute Notre Logique Métier : Le Modèle de Domaine

Mais avant de pouvoir retourner notre architecture à trois couches, nous devons parler davantage de cette couche intermédiaire : les modules de haut niveau ou la logique métier. L’une des raisons les plus courantes pour lesquelles nos conceptions tournent mal est que la logique métier se retrouve dispersée dans les couches de notre application, ce qui rend difficile son identification, sa compréhension et sa modification.

Le Modélisation du Domaine montre comment construire une couche métier avec un pattern de Modèle de Domaine (Domain Model). Le reste des patterns de la Construire une Architecture pour Supporter la Modélisation de Domaine montre comment nous pouvons garder le Modèle de Domaine facile à changer et libre de préoccupations de bas niveau en choisissant les bonnes abstractions et en appliquant continuellement le DIP.

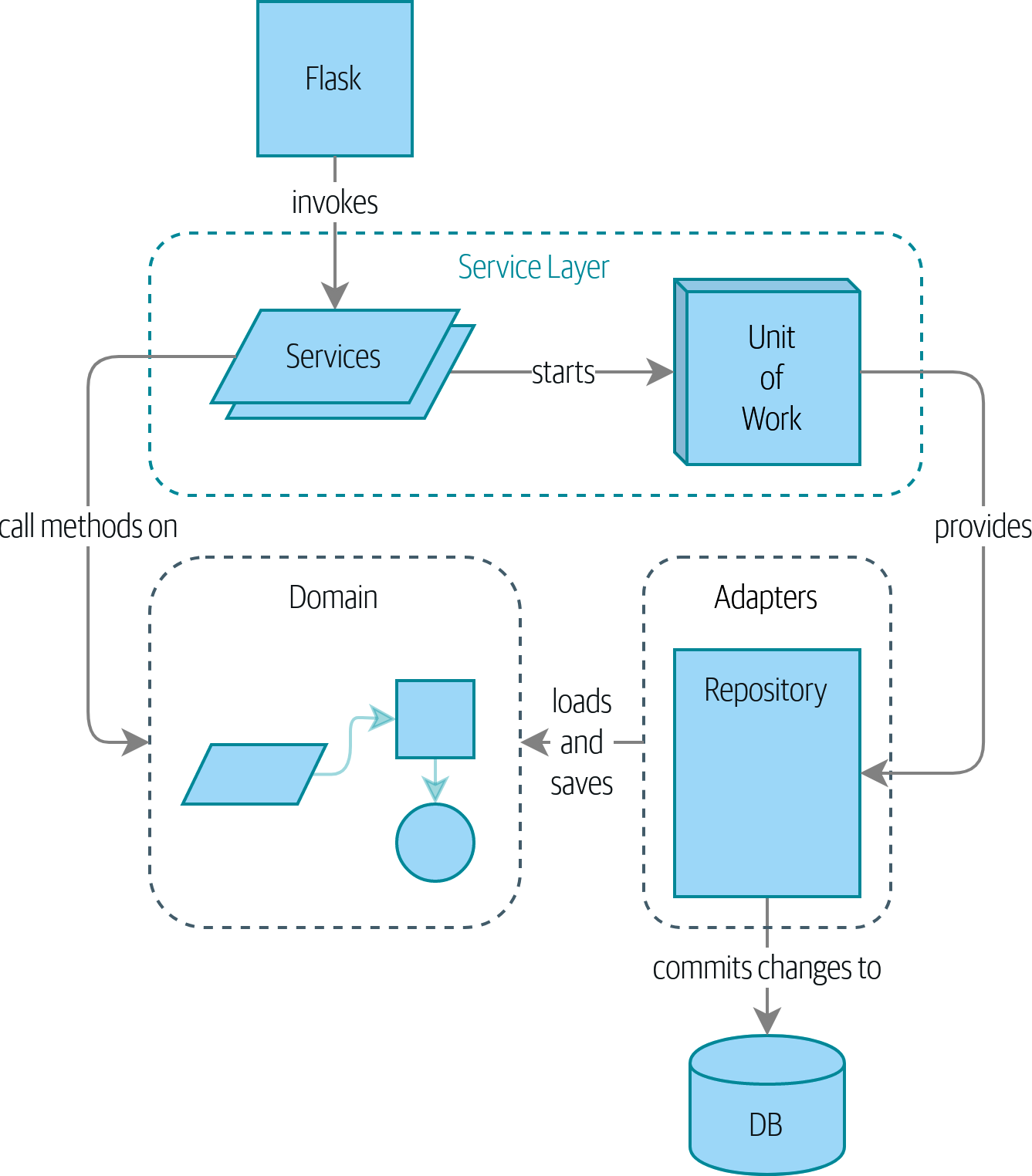

Construire une Architecture pour Supporter la Modélisation de Domaine

La plupart des développeurs n’ont jamais vu un modèle de domaine, seulement un modèle de données.

DDD EU 2017

La plupart des développeurs à qui nous parlons d’architecture ont le sentiment tenace que les choses pourraient être meilleures. Ils essaient souvent de sauver un système qui a mal tourné d’une manière ou d’une autre, et tentent de remettre de la structure dans une boule de boue. Ils savent que leur logique métier ne devrait pas être éparpillée partout, mais ils n’ont aucune idée de comment la corriger.

Nous avons constaté que de nombreux développeurs, lorsqu’on leur demande de concevoir un nouveau système, commenceront immédiatement à construire un schéma de base de données, avec le modèle objet traité comme une réflexion après coup. C’est là que tout commence à mal tourner. Au lieu de cela, le comportement devrait venir en premier et piloter nos exigences de stockage. Après tout, nos clients ne se soucient pas du modèle de données. Ils se soucient de ce que le système fait ; sinon ils utiliseraient simplement un tableur.

La première partie du livre examine comment construire un modèle objet riche à travers le TDD (dans le Modélisation du Domaine), puis nous montrerons comment garder ce modèle découplé des préoccupations techniques. Nous montrons comment construire du code ignorant la persistance et comment créer des APIs stables autour de notre domaine afin que nous puissions refactoriser de manière agressive.

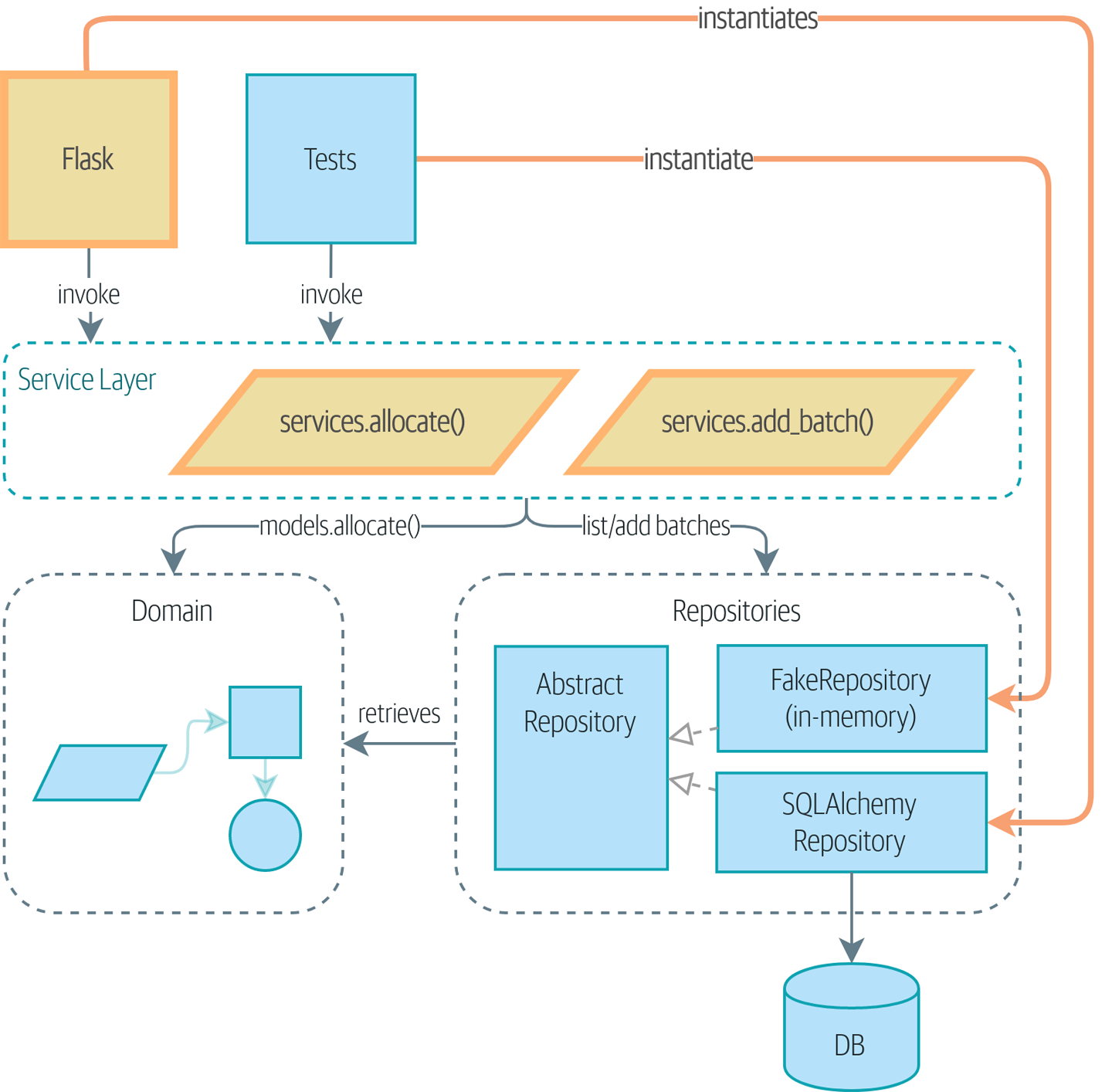

Pour ce faire, nous présentons quatre patterns de conception clés :

-

Le pattern Dépôt (Repository), une abstraction sur l’idée de stockage persistant

-

Le pattern Couche de Service (Service Layer) pour définir clairement où nos cas d’usage commencent et se terminent

-

Le pattern Unité de Travail (Unit of Work) pour fournir des opérations atomiques

-

Le pattern Agrégat (Aggregate) pour faire respecter l’intégrité de nos données

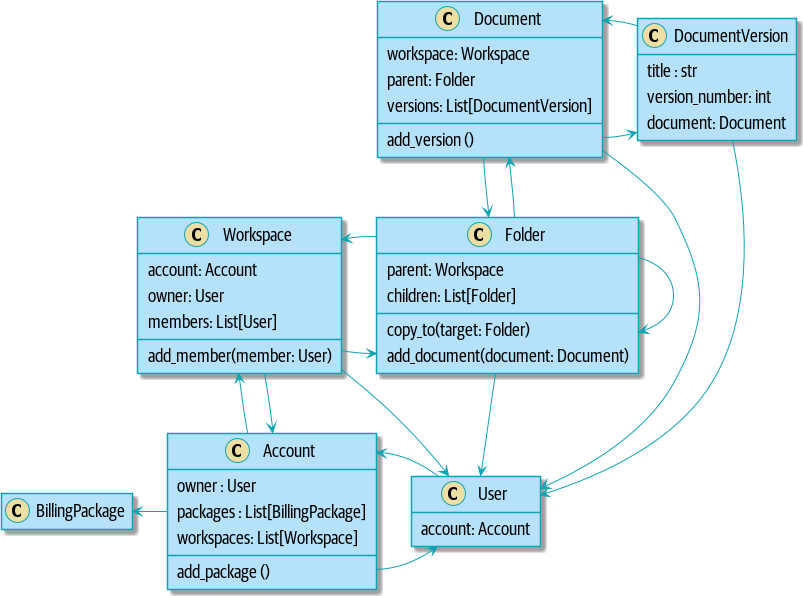

Si vous aimeriez avoir une image de où nous allons, jetez un œil à Un diagramme de composants pour notre application à la fin de [part1], mais ne vous inquiétez pas si rien n’a de sens encore ! Nous introduisons chaque boîte dans la figure, une par une, tout au long de cette partie du livre.

Nous prenons également un peu de temps pour parler du couplage et des abstractions, en l’illustrant avec un exemple simple qui montre comment et pourquoi nous choisissons nos abstractions.

Trois annexes sont des explorations supplémentaires du contenu de la Partie I :

-

Une Structure de Projet Modèle est une description de l’infrastructure pour notre code d’exemple : comment nous construisons et exécutons les images Docker, où nous gérons les informations de configuration, et comment nous exécutons différents types de tests.

-

Remplacer l’Infrastructure : Tout Faire avec des CSVs est un contenu du genre "la preuve est dans le pudding", montrant combien il est facile de remplacer toute notre infrastructure—l’API Flask, l' ORM, et Postgres—par un modèle d’E/S totalement différent impliquant un CLI et des CSVs.

-

Enfin, Motifs Dépôt (Repository) et Unité de Travail (Unit of Work) avec Django peut être intéressant si vous vous demandez à quoi ces patterns pourraient ressembler en utilisant Django au lieu de Flask et SQLAlchemy.

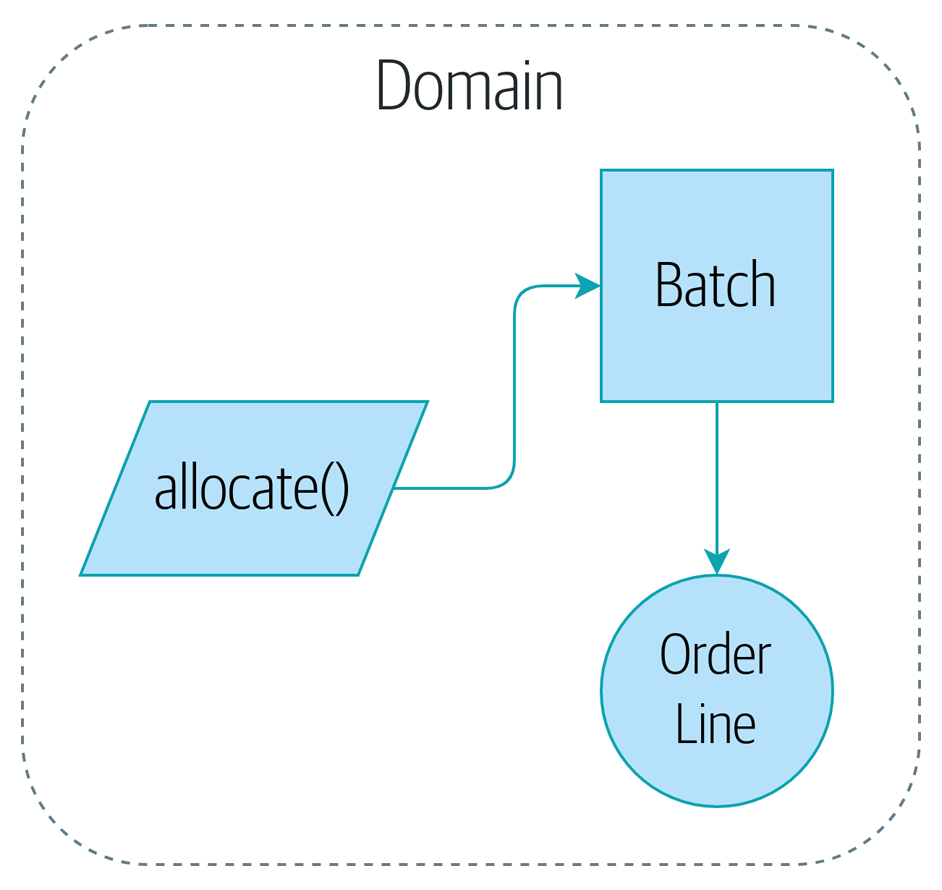

1. Modélisation du Domaine

Ce chapitre examine comment nous pouvons modéliser des processus métier avec du code, d’une manière hautement compatible avec le TDD. Nous discuterons pourquoi la modélisation du domaine est importante, et nous examinerons quelques patterns clés pour modéliser les domaines : Entité (Entity), Objet Valeur (Value Object), et Service de Domaine (Domain Service).

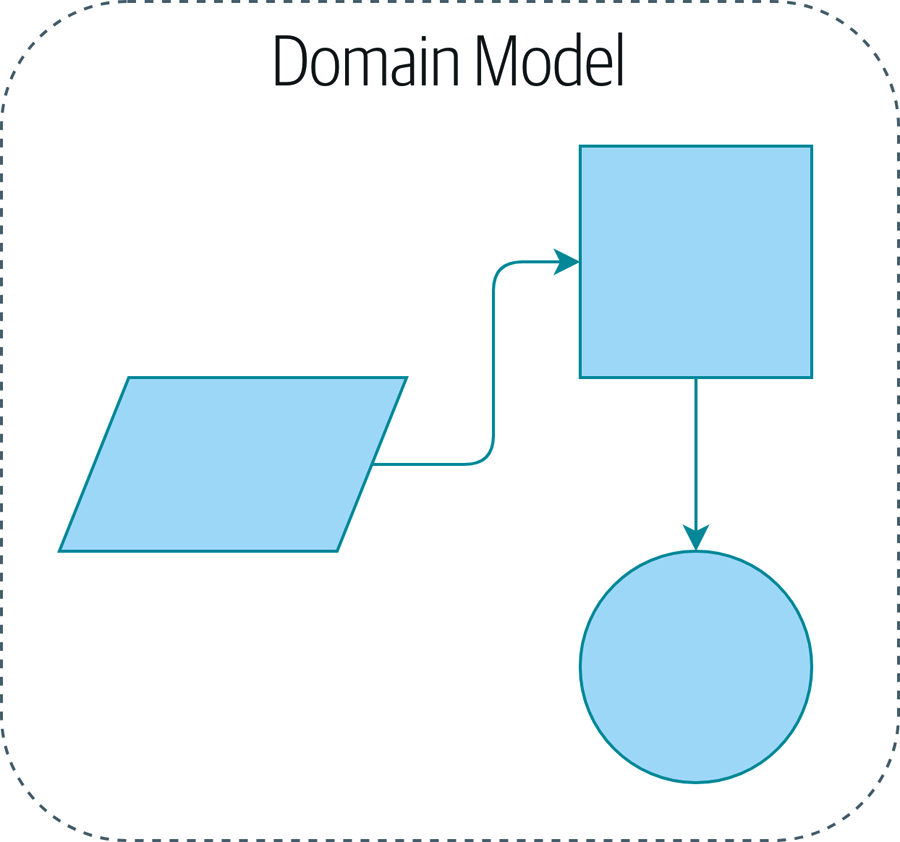

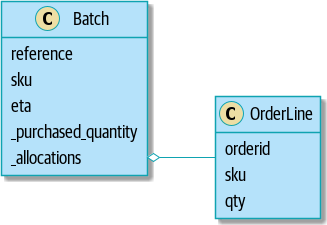

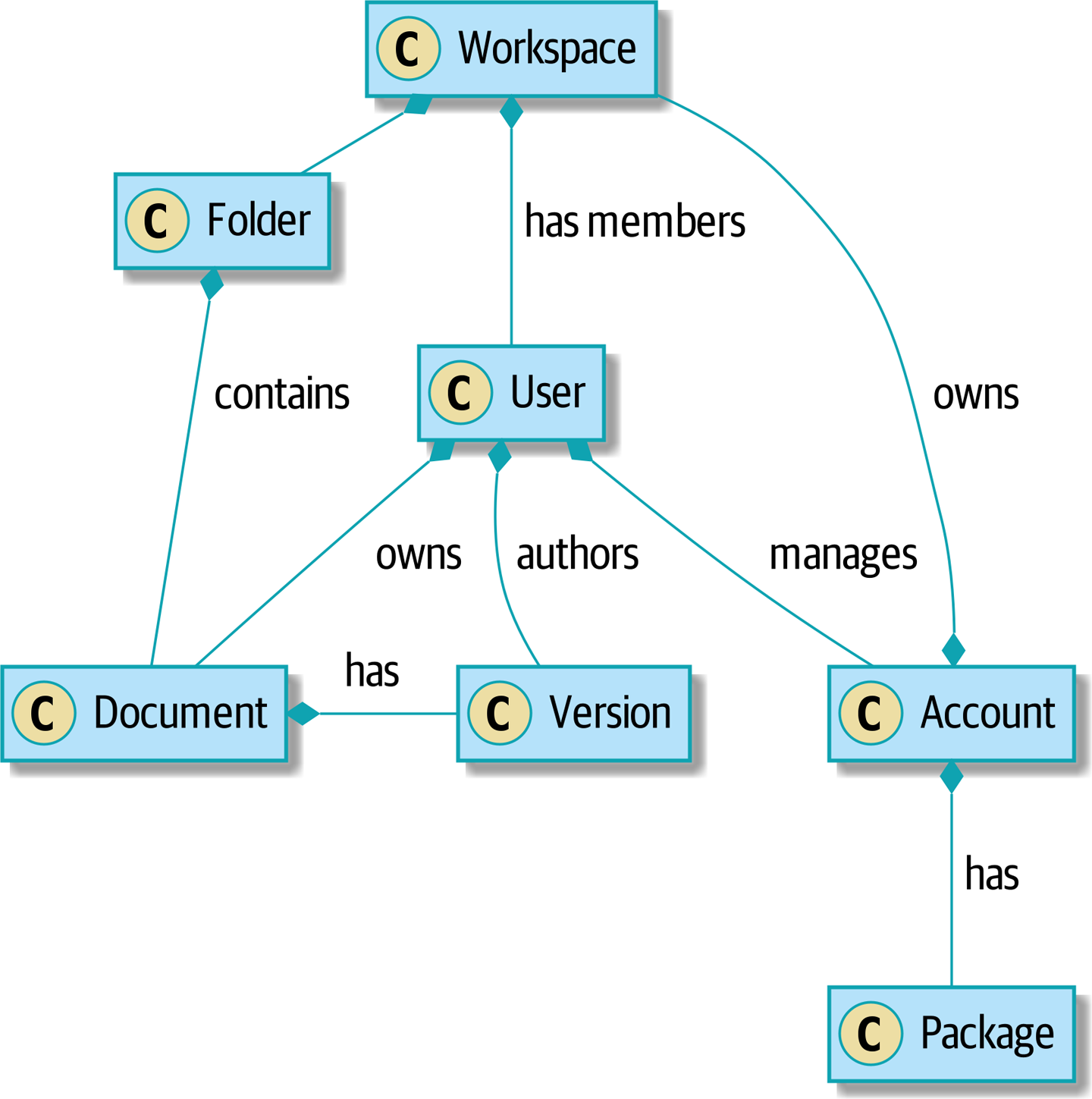

Une illustration temporaire de notre modèle de domaine est un simple support visuel pour notre pattern de Modèle de Domaine (Domain Model). Nous ajouterons quelques détails dans ce chapitre, et au fur et à mesure que nous avancerons vers d’autres chapitres, nous construirons des éléments autour du modèle de domaine, mais vous devriez toujours être capable de retrouver ces petites formes au cœur.

1.1. Qu’est-ce qu’un Modèle de Domaine ?

Dans l'introduction, nous avons utilisé le terme couche de logique métier pour décrire la couche centrale d’une architecture à trois couches. Pour le reste du livre, nous allons utiliser le terme modèle de domaine à la place. C’est un terme de la communauté DDD qui exprime mieux notre intention (voir l’encadré suivant pour plus d’informations sur le DDD).

Le domaine est une façon élégante de dire le problème que vous essayez de résoudre. Vos auteurs travaillent actuellement pour un détaillant en ligne de meubles. Selon le système dont vous parlez, le domaine peut être les achats et l’approvisionnement, ou la conception de produits, ou la logistique et la livraison. La plupart des programmeurs passent leurs journées à essayer d’améliorer ou d’automatiser des processus métier ; le domaine est l’ensemble des activités que ces processus supportent.

Un modèle est une carte d’un processus ou d’un phénomène qui capture une propriété utile. Les humains sont exceptionnellement doués pour produire des modèles de choses dans leur tête. Par exemple, quand quelqu’un vous lance une balle, vous êtes capable de prédire son mouvement presque inconsciemment, parce que vous avez un modèle de la façon dont les objets se déplacent dans l’espace. Votre modèle n’est en aucun cas parfait. Les humains ont de terribles intuitions sur la façon dont les objets se comportent à des vitesses proches de la lumière ou dans le vide parce que notre modèle n’a jamais été conçu pour couvrir ces cas. Cela ne signifie pas que le modèle est faux, mais cela signifie que certaines prédictions tombent en dehors de son domaine.

Le modèle de domaine est la carte mentale que les propriétaires d’entreprises ont de leurs entreprises. Tous les gens d’affaires ont ces cartes mentales—c’est ainsi que les humains pensent aux processus complexes.

Vous pouvez dire quand ils naviguent dans ces cartes parce qu’ils utilisent le jargon métier. Le jargon apparaît naturellement parmi les personnes qui collaborent sur des systèmes complexes.

Imaginez que vous, notre malheureux lecteur, soyez soudainement transporté à des années-lumière de la Terre à bord d’un vaisseau spatial alien avec vos amis et votre famille et deviez comprendre, à partir de premiers principes, comment naviguer pour rentrer chez vous.

Dans vos premiers jours, vous pourriez simplement appuyer sur des boutons au hasard, mais bientôt vous apprendriez quels boutons font quoi, afin que vous puissiez vous donner des instructions les uns aux autres. "Appuyez sur le bouton rouge près du machin clignotant et ensuite tirez ce gros levier là-bas près du truc radar," pourriez-vous dire.

En quelques semaines, vous deviendriez plus précis en adoptant des mots pour décrire les fonctions du vaisseau : "Augmentez les niveaux d’oxygène dans la soute trois" ou "allumez les petits propulseurs." Après quelques mois, vous auriez adopté un langage pour des processus complexes entiers : "Commencer la séquence d’atterrissage" ou "préparer pour la distorsion." Ce processus se produirait de manière tout à fait naturelle, sans aucun effort formel pour construire un glossaire partagé.

Il en va de même dans le monde banal des affaires. La terminologie utilisée par les parties prenantes métier représente une compréhension distillée du modèle de domaine, où des idées et des processus complexes sont réduits à un seul mot ou phrase.

Quand nous entendons nos parties prenantes métier utiliser des mots inconnus, ou utiliser des termes d’une manière spécifique, nous devrions écouter pour comprendre le sens plus profond et encoder leur expérience durement acquise dans notre logiciel.

Nous allons utiliser un modèle de domaine du monde réel tout au long de ce livre, spécifiquement un modèle de notre emploi actuel. MADE.com est un détaillant de meubles prospère. Nous nous approvisionnons en meubles auprès de fabricants du monde entier et les vendons à travers l’Europe.

Quand vous achetez un canapé ou une table basse, nous devons déterminer comment amener vos biens de Pologne ou de Chine ou du Vietnam dans votre salon.

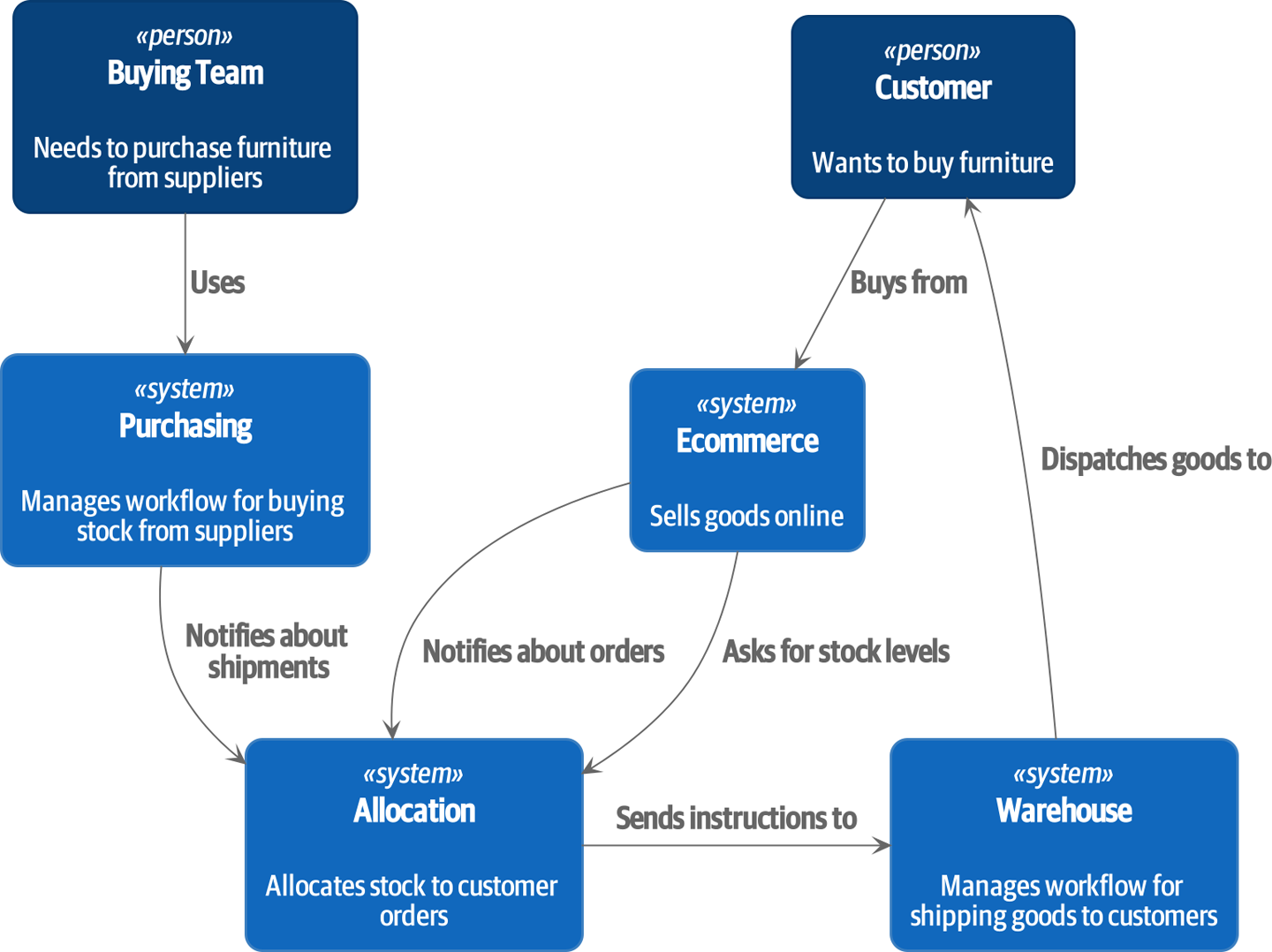

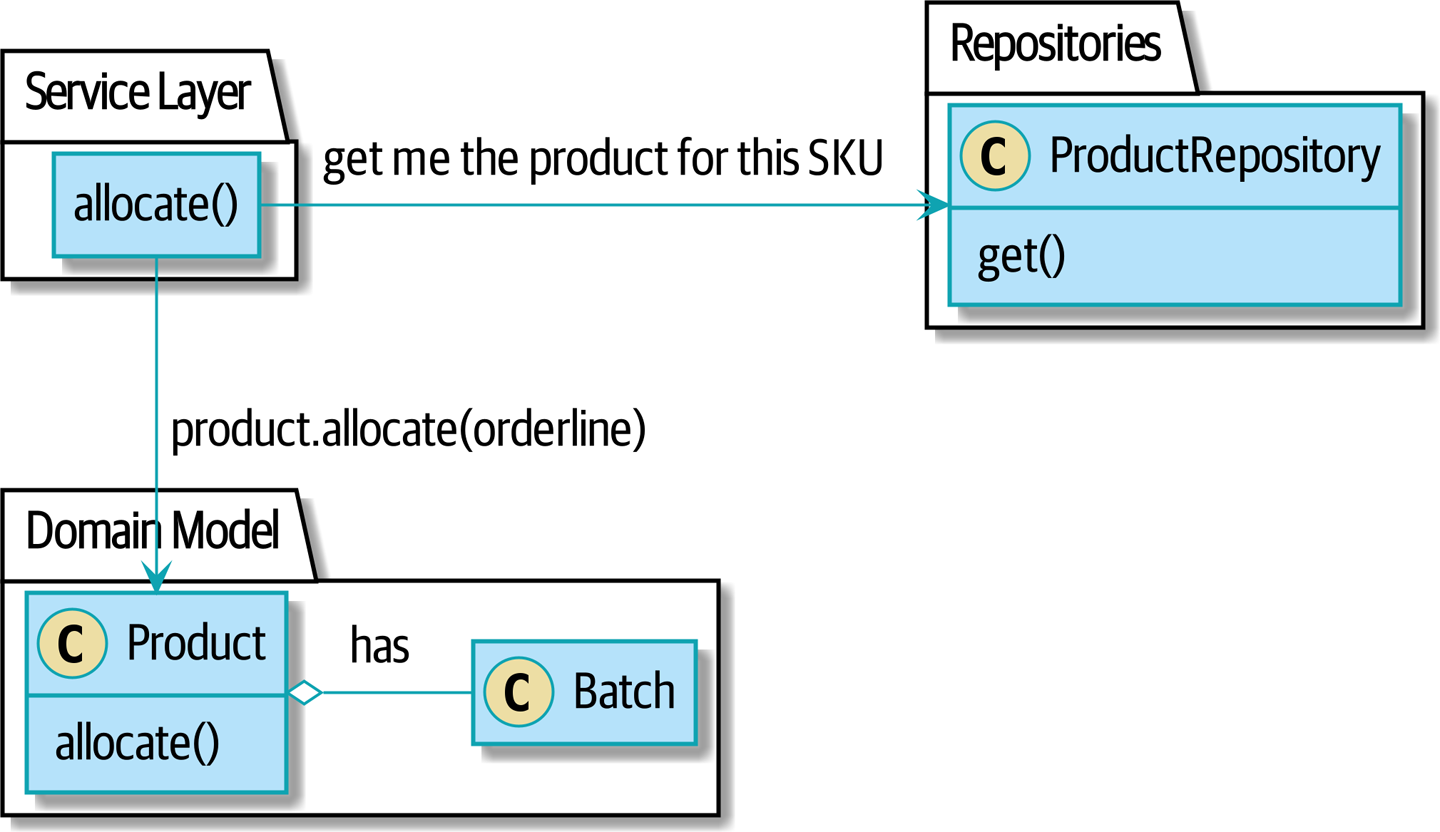

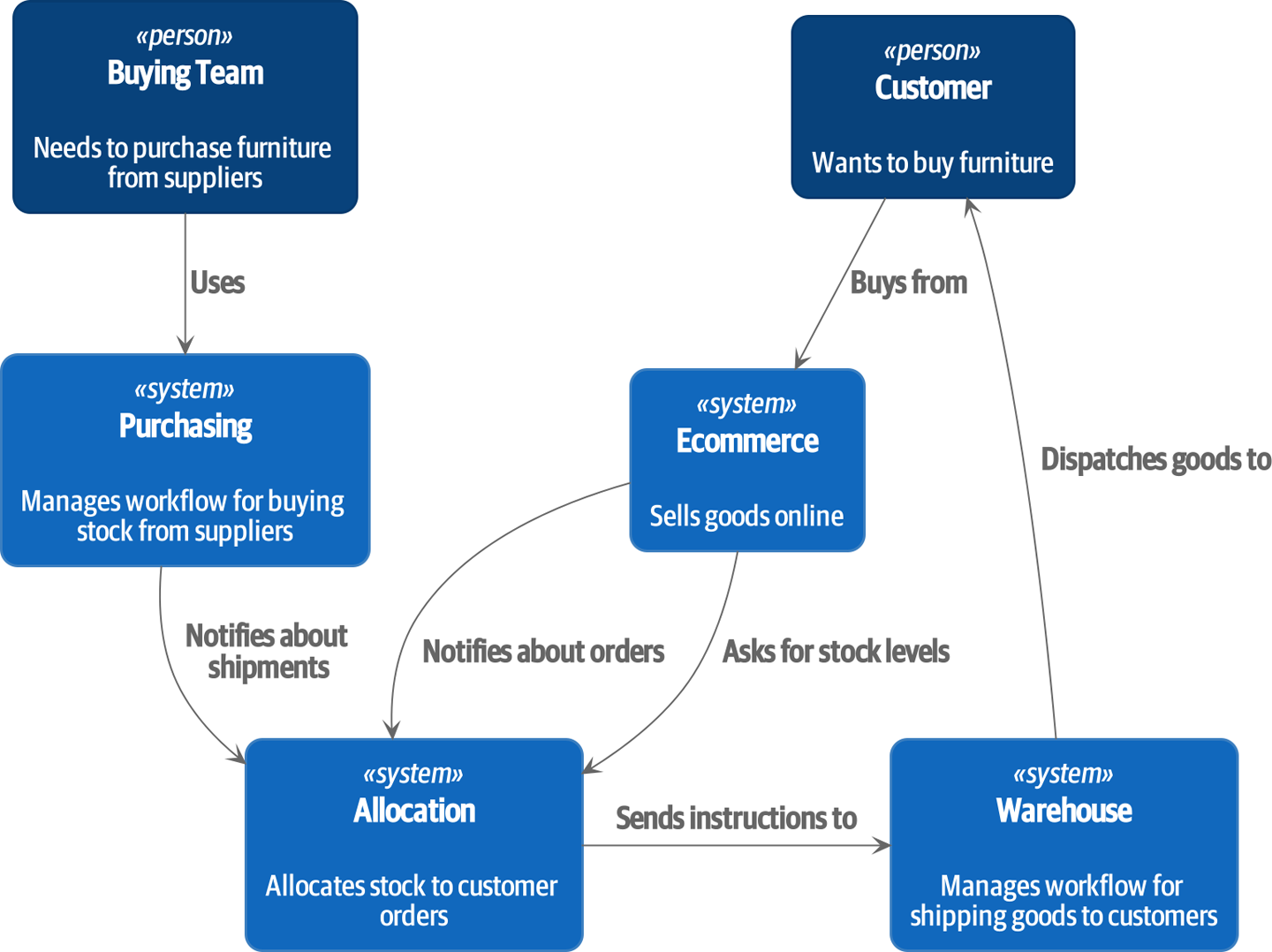

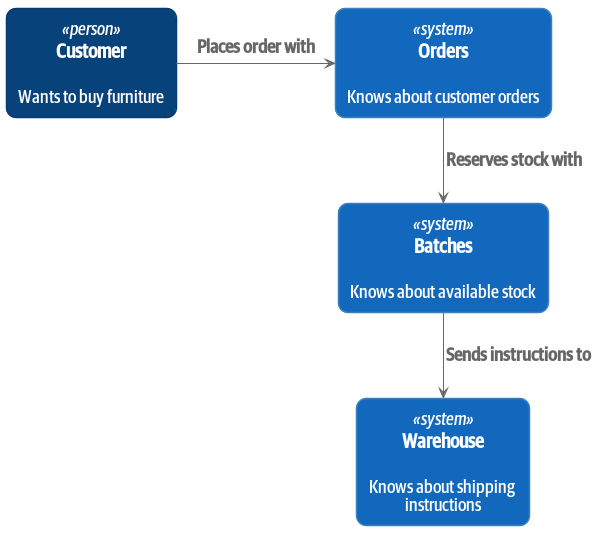

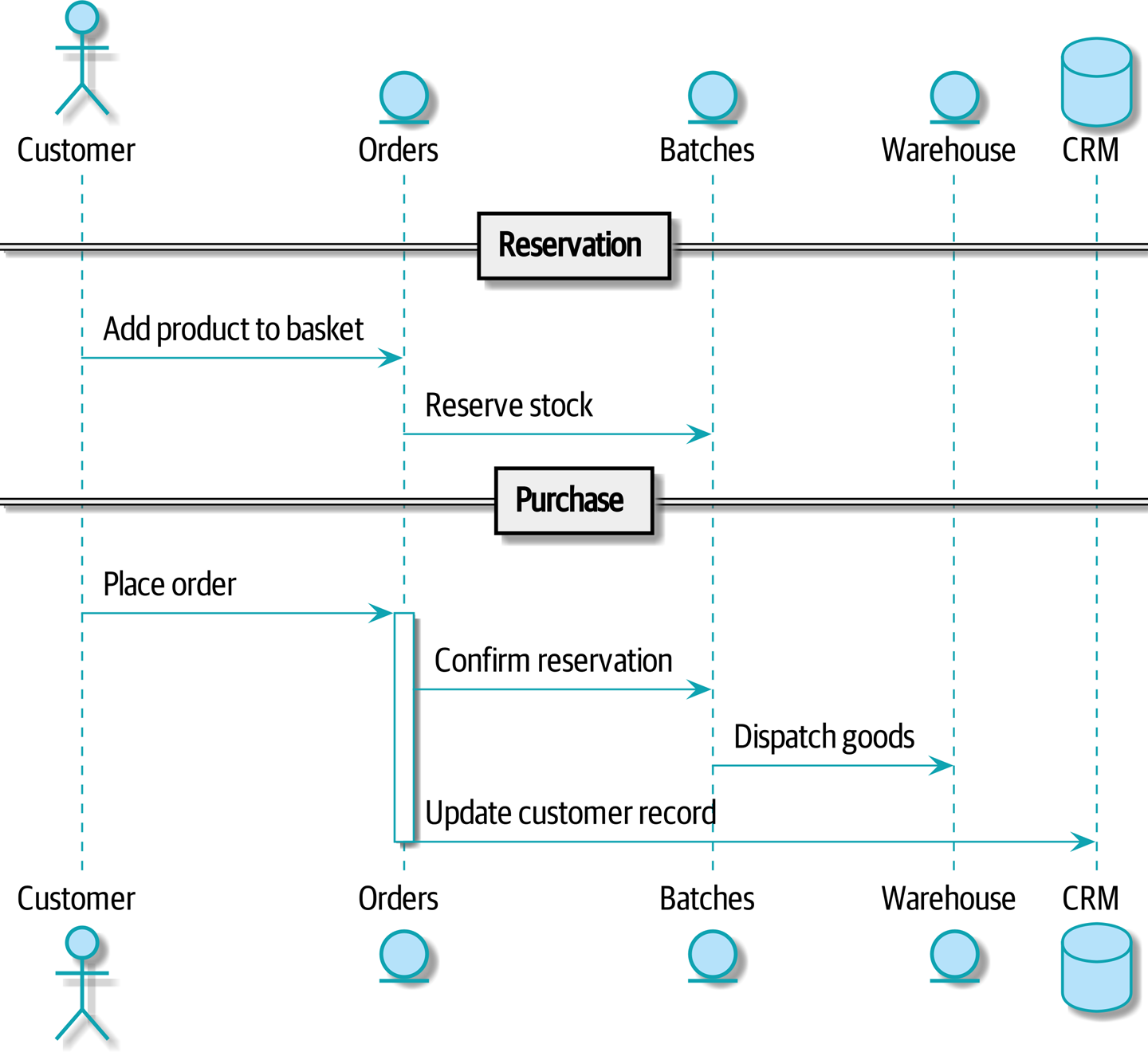

À un haut niveau, nous avons des systèmes séparés qui sont responsables de l’achat de stock, de la vente de stock aux clients, et de l’expédition de biens aux clients. Un système au milieu doit coordonner le processus en allouant le stock aux commandes des clients ; voir Diagramme de contexte pour le service d’allocation.

[plantuml, apwp_0102] @startuml Allocation Context Diagram !include images/C4_Context.puml scale 2 System(systema, "Allocation", "Allocates stock to customer orders") Person(customer, "Customer", "Wants to buy furniture") Person(buyer, "Buying Team", "Needs to purchase furniture from suppliers") System(procurement, "Purchasing", "Manages workflow for buying stock from suppliers") System(ecom, "Ecommerce", "Sells goods online") System(warehouse, "Warehouse", "Manages workflow for shipping goods to customers") Rel(buyer, procurement, "Uses") Rel(procurement, systema, "Notifies about shipments") Rel(customer, ecom, "Buys from") Rel(ecom, systema, "Asks for stock levels") Rel(ecom, systema, "Notifies about orders") Rel_R(systema, warehouse, "Sends instructions to") Rel_U(warehouse, customer, "Dispatches goods to") @enduml

Pour les besoins de ce livre, nous imaginons que l’entreprise décide de mettre en œuvre une nouvelle façon passionnante d’allouer le stock. Jusqu’à présent, l' entreprise a présenté le stock et les délais de livraison en fonction de ce qui est physiquement disponible dans l’entrepôt. Si et quand l’entrepôt est en rupture de stock, un produit est listé comme "en rupture de stock" jusqu’à la prochaine livraison du fabricant.

Voici l’innovation : si nous avons un système qui peut suivre toutes nos livraisons et quand elles sont censées arriver, nous pouvons traiter les biens sur ces navires comme du stock réel et une partie de notre inventaire, juste avec des délais de livraison légèrement plus longs. Moins de biens apparaîtront comme étant en rupture de stock, nous vendrons plus, et l’entreprise peut économiser de l’argent en gardant un inventaire plus faible dans l’entrepôt domestique.

Mais allouer des commandes n’est plus une question triviale de décrémenter une seule quantité dans le système de l’entrepôt. Nous avons besoin d’un mécanisme d’allocation plus complexe. Il est temps de faire de la modélisation du domaine.

1.2. Explorer le Langage du Domaine

Comprendre le modèle de domaine prend du temps, de la patience et des Post-it. Nous avons une conversation initiale avec nos experts métier et nous nous mettons d’accord sur un glossaire et quelques règles pour la première version minimale du modèle de domaine. Dans la mesure du possible, nous demandons des exemples concrets pour illustrer chaque règle.

Nous nous assurons d’exprimer ces règles dans le jargon métier (le langage omniprésent dans la terminologie DDD). Nous choisissons des identifiants mémorables pour nos objets afin que les exemples soient plus faciles à discuter.

L’encadré suivant montre quelques notes que nous aurions pu prendre en ayant une conversation avec nos experts du domaine sur l’allocation.

1.3. Tests Unitaires des Modèles de Domaine

Nous n’allons pas vous montrer comment fonctionne le TDD dans ce livre, mais nous voulons vous montrer comment nous construirions un modèle à partir de cette conversation métier.

Voici à quoi pourrait ressembler l’un de nos premiers tests :

def test_allocating_to_a_batch_reduces_the_available_quantity():

batch = Batch("batch-001", "SMALL-TABLE", qty=20, eta=date.today())

line = OrderLine("order-ref", "SMALL-TABLE", 2)

batch.allocate(line)

assert batch.available_quantity == 18Le nom de notre test unitaire décrit le comportement que nous voulons voir du système, et les noms des classes et variables que nous utilisons sont tirés du jargon métier. Nous pourrions montrer ce code à nos collègues non techniques, et ils seraient d’accord que cela décrit correctement le comportement du système.

Et voici un modèle de domaine qui répond à nos exigences :

@dataclass(frozen=True) (1) (2)

class OrderLine:

orderid: str

sku: str

qty: int

class Batch:

def __init__(self, ref: str, sku: str, qty: int, eta: Optional[date]): (2)

self.reference = ref

self.sku = sku

self.eta = eta

self.available_quantity = qty

def allocate(self, line: OrderLine): (3)

self.available_quantity -= line.qty| 1 | OrderLine est une dataclass immuable

sans comportement.[5] |

| 2 | Nous ne montrons pas les imports dans la plupart des listings de code, dans une tentative de les garder

propres. Nous espérons que vous pouvez deviner

que cela vient via from dataclasses import dataclass ; de même,

typing.Optional et datetime.date. Si vous voulez vérifier

quoi que ce soit, vous pouvez voir le code complet fonctionnel pour chaque chapitre dans

sa branche (par exemple,

chapter_01_domain_model). |

| 3 | Les annotations de type sont encore une question de controverse dans le monde Python. Pour les modèles de domaine, elles peuvent parfois aider à clarifier ou documenter quels sont les arguments attendus, et les personnes avec des IDE sont souvent reconnaissantes pour elles. Vous pouvez décider que le prix payé en termes de lisibilité est trop élevé. |

Notre implémentation ici est triviale :

un Batch enveloppe simplement un entier available_quantity,

et nous décrémentons cette valeur lors de l’allocation.

Nous avons écrit beaucoup de code juste pour soustraire un nombre d’un autre,

mais nous pensons que modéliser notre domaine avec précision sera payant.[6]

Écrivons quelques nouveaux tests qui échouent :

def make_batch_and_line(sku, batch_qty, line_qty):

return (

Batch("batch-001", sku, batch_qty, eta=date.today()),

OrderLine("order-123", sku, line_qty),

)

def test_can_allocate_if_available_greater_than_required():

large_batch, small_line = make_batch_and_line("ELEGANT-LAMP", 20, 2)

assert large_batch.can_allocate(small_line)

def test_cannot_allocate_if_available_smaller_than_required():

small_batch, large_line = make_batch_and_line("ELEGANT-LAMP", 2, 20)

assert small_batch.can_allocate(large_line) is False

def test_can_allocate_if_available_equal_to_required():

batch, line = make_batch_and_line("ELEGANT-LAMP", 2, 2)

assert batch.can_allocate(line)

def test_cannot_allocate_if_skus_do_not_match():

batch = Batch("batch-001", "UNCOMFORTABLE-CHAIR", 100, eta=None)

different_sku_line = OrderLine("order-123", "EXPENSIVE-TOASTER", 10)

assert batch.can_allocate(different_sku_line) is FalseIl n’y a rien de trop inattendu ici. Nous avons refactorisé notre suite de tests pour que nous

ne répétions pas les mêmes lignes de code pour créer un lot et une ligne pour

le même SKU ; et nous avons écrit quatre tests simples pour une nouvelle méthode

can_allocate. Encore une fois, remarquez que les noms que nous utilisons reflètent le langage de nos

experts du domaine, et les exemples sur lesquels nous nous sommes mis d’accord sont directement écrits dans le code.

Nous pouvons implémenter cela de manière simple, aussi, en écrivant la méthode can_allocate

de Batch :

def can_allocate(self, line: OrderLine) -> bool:

return self.sku == line.sku and self.available_quantity >= line.qtyJusqu’à présent, nous pouvons gérer l’implémentation en incrémentant et décrémentant simplement

Batch.available_quantity, mais au fur et à mesure que nous entrons dans les tests deallocate(), nous serons

forcés vers une solution plus intelligente :

def test_can_only_deallocate_allocated_lines():

batch, unallocated_line = make_batch_and_line("DECORATIVE-TRINKET", 20, 2)

batch.deallocate(unallocated_line)

assert batch.available_quantity == 20Dans ce test, nous affirmons que désallouer une ligne d’un lot n’a aucun effet

à moins que le lot n’ait précédemment alloué la ligne. Pour que cela fonctionne, notre Batch

doit comprendre quelles lignes ont été allouées. Regardons l'

implémentation :

class Batch:

def __init__(self, ref: str, sku: str, qty: int, eta: Optional[date]):

self.reference = ref

self.sku = sku

self.eta = eta

self._purchased_quantity = qty

self._allocations = set() # type: Set[OrderLine]

def allocate(self, line: OrderLine):

if self.can_allocate(line):

self._allocations.add(line)

def deallocate(self, line: OrderLine):

if line in self._allocations:

self._allocations.remove(line)

@property

def allocated_quantity(self) -> int:

return sum(line.qty for line in self._allocations)

@property

def available_quantity(self) -> int:

return self._purchased_quantity - self.allocated_quantity

def can_allocate(self, line: OrderLine) -> bool:

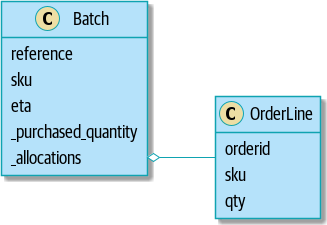

return self.sku == line.sku and self.available_quantity >= line.qtyNotre modèle en UML montre le modèle en UML.

[plantuml, apwp_0103, config=plantuml.cfg]

@startuml

scale 4

left to right direction

hide empty members

class Batch {

reference

sku

eta

_purchased_quantity

_allocations

}

class OrderLine {

orderid

sku

qty

}

Batch::_allocations o-- OrderLine

Maintenant nous progressons ! Un lot garde maintenant la trace d’un ensemble d’objets

OrderLine alloués. Quand nous allouons, si nous avons assez de quantité disponible, nous

ajoutons simplement à l’ensemble. Notre available_quantity est maintenant une propriété calculée :

quantité achetée moins quantité allouée.

Oui, il y a beaucoup plus que nous pourrions faire. C’est un peu déconcertant que

allocate() et deallocate() puissent échouer silencieusement, mais nous avons les

bases.

Incidemment, utiliser un ensemble pour ._allocations nous facilite la tâche pour

gérer le dernier test, parce que les éléments dans un ensemble sont uniques :

def test_allocation_is_idempotent():

batch, line = make_batch_and_line("ANGULAR-DESK", 20, 2)

batch.allocate(line)

batch.allocate(line)

assert batch.available_quantity == 18Pour le moment, c’est probablement une critique valable de dire que le modèle de domaine est trop trivial pour s’embêter avec le DDD (ou même l’orientation objet !). Dans la vraie vie, un nombre quelconque de règles métier et de cas particuliers apparaissent : les clients peuvent demander une livraison à des dates futures spécifiques, ce qui signifie que nous ne voudrons peut-être pas les allouer au lot le plus tôt. Certains SKU ne sont pas dans des lots, mais commandés sur demande directement auprès des fournisseurs, donc ils ont une logique différente. Selon l’emplacement du client, nous ne pouvons allouer qu’à un sous-ensemble d’entrepôts et de livraisons qui sont dans leur région—sauf pour certains SKU que nous sommes heureux de livrer depuis un entrepôt dans une région différente si nous sommes en rupture de stock dans la région d’origine. Et ainsi de suite. Une vraie entreprise dans le monde réel sait comment empiler la complexité plus rapidement que nous ne pouvons le montrer sur la page !

Mais en prenant ce modèle de domaine simple comme un espace réservé pour quelque chose de plus complexe, nous allons étendre notre modèle de domaine simple dans le reste du livre et le connecter au monde réel des API, des bases de données et des feuilles de calcul. Nous verrons comment s’en tenir rigoureusement à nos principes d’encapsulation et de découpage soigneux nous aidera à éviter une boule de boue.

1.3.1. Les Dataclasses sont idéales pour les Objets Valeur

Nous avons utilisé line libéralement dans les listings de code précédents, mais qu’est-ce qu’une

ligne ? Dans notre langage métier, une commande a plusieurs lignes d’articles, où

chaque ligne a un SKU et une quantité. Nous pouvons imaginer qu’un simple fichier YAML

contenant des informations de commande pourrait ressembler à ceci :

Order_reference: 12345

Lines:

- sku: RED-CHAIR

qty: 25

- sku: BLU-CHAIR

qty: 25

- sku: GRN-CHAIR

qty: 25Remarquez que bien qu’une commande ait une référence qui l’identifie de manière unique, une

ligne n’en a pas. (Même si nous ajoutons la référence de commande à la classe OrderLine,

ce n’est pas quelque chose qui identifie de manière unique la ligne elle-même.)

Chaque fois que nous avons un concept métier qui a des données mais pas d’identité, nous choisissons souvent de le représenter en utilisant le pattern Objet Valeur (Value Object). Un objet valeur est tout objet du domaine qui est uniquement identifié par les données qu’il contient ; nous les rendons généralement immuables :

@dataclass(frozen=True)

class OrderLine:

orderid: OrderReference

sku: ProductReference

qty: Quantity

L’une des belles choses que les dataclasses (ou namedtuples) nous donnent est l'égalité

de valeur, qui est la façon élégante de dire : "Deux lignes avec le même orderid,

sku et qty sont égales."

from dataclasses import dataclass

from typing import NamedTuple

from collections import namedtuple

@dataclass(frozen=True)

class Name:

first_name: str

surname: str

class Money(NamedTuple):

currency: str

value: int

Line = namedtuple('Line', ['sku', 'qty'])

def test_equality():

assert Money('gbp', 10) == Money('gbp', 10)

assert Name('Harry', 'Percival') != Name('Bob', 'Gregory')

assert Line('RED-CHAIR', 5) == Line('RED-CHAIR', 5)Ces objets valeur correspondent à notre intuition du monde réel sur la façon dont leurs valeurs fonctionnent. Peu importe quel billet de 10 £ dont nous parlons, parce qu’ils ont tous la même valeur. De même, deux noms sont égaux si les prénoms et les noms de famille correspondent ; et deux lignes sont équivalentes si elles ont la même commande client, code produit et quantité. Nous pouvons toujours avoir un comportement complexe sur un objet valeur, cependant. En fait, il est courant de supporter des opérations sur les valeurs ; par exemple, les opérateurs mathématiques :

fiver = Money('gbp', 5)

tenner = Money('gbp', 10)

def can_add_money_values_for_the_same_currency():

assert fiver + fiver == tenner

def can_subtract_money_values():

assert tenner - fiver == fiver

def adding_different_currencies_fails():

with pytest.raises(ValueError):

Money('usd', 10) + Money('gbp', 10)

def can_multiply_money_by_a_number():

assert fiver * 5 == Money('gbp', 25)

def multiplying_two_money_values_is_an_error():

with pytest.raises(TypeError):

tenner * fiver

Pour que ces tests passent réellement, vous devrez commencer à implémenter quelques

méthodes magiques sur notre classe Money :

@dataclass(frozen=True)

class Money:

currency: str

value: int

def __add__(self, other) -> Money:

if other.currency != self.currency:

raise ValueError(f"Cannot add {self.currency} to {other.currency}")

return Money(self.currency, self.value + other.value)1.3.2. Objets Valeur et Entités

Une ligne de commande est uniquement identifiée par son ID de commande, son SKU et sa quantité ; si nous changeons l’une de ces valeurs, nous avons maintenant une nouvelle ligne. C’est la définition d’un objet valeur : tout objet qui n’est identifié que par ses données et n’a pas une identité de longue durée. Qu’en est-il d’un lot, cependant ? Il est identifié par une référence.

Nous utilisons le terme entité pour décrire un objet du domaine qui a une

identité de longue durée. Sur la page précédente, nous avons introduit une classe Name comme objet valeur.

Si nous prenons le nom Harry Percival et changeons une lettre, nous avons le nouvel

objet Name Barry Percival.

Il devrait être clair que Harry Percival n’est pas égal à Barry Percival :

def test_name_equality():

assert Name("Harry", "Percival") != Name("Barry", "Percival")Mais qu’en est-il de Harry en tant que personne ? Les gens changent effectivement leurs noms, et leur statut matrimonial, et même leur genre, mais nous continuons à les reconnaître comme le même individu. C’est parce que les humains, contrairement aux noms, ont une identité persistante :

class Person:

def __init__(self, name: Name):

self.name = name

def test_barry_is_harry():

harry = Person(Name("Harry", "Percival"))

barry = harry

barry.name = Name("Barry", "Percival")

assert harry is barry and barry is harryLes entités, contrairement aux valeurs, ont une égalité d’identité. Nous pouvons changer leurs valeurs, et elles sont toujours reconnaissables comme étant la même chose. Les lots, dans notre exemple, sont des entités. Nous pouvons allouer des lignes à un lot, ou changer la date à laquelle nous nous attendons à ce qu’il arrive, et ce sera toujours la même entité.

Nous rendons généralement cela explicite dans le code en implémentant des opérateurs d’égalité sur les entités :

class Batch:

...

def __eq__(self, other):

if not isinstance(other, Batch):

return False

return other.reference == self.reference

def __hash__(self):

return hash(self.reference)

La méthode magique __eq__ de Python

définit le comportement de la classe pour l’opérateur ==.[7]

Pour les objets entités et objets valeur, il vaut également la peine de réfléchir à comment

__hash__ fonctionnera. C’est la méthode magique que Python utilise pour contrôler le

comportement des objets quand vous les ajoutez à des ensembles ou les utilisez comme clés de dictionnaire ;

vous pouvez trouver plus d’informations dans la documentation Python.

Pour les objets valeur, le hash devrait être basé sur tous les attributs de valeur,

et nous devrions nous assurer que les objets sont immuables. Nous obtenons cela gratuitement

en spécifiant @frozen=True sur la dataclass.

Pour les entités, l’option la plus simple est de dire que le hash est None, ce qui signifie

que l’objet n’est pas hashable et ne peut pas, par exemple, être utilisé dans un ensemble.

Si pour une raison quelconque vous décidez que vous voulez vraiment utiliser des opérations d’ensemble ou de dictionnaire

avec des entités, le hash devrait être basé sur l’attribut (ou les attributs), tel que

.reference, qui définit l’identité unique de l’entité dans le temps. Vous devriez

également essayer de rendre cet attribut en lecture seule d’une manière ou d’une autre.

C’est un territoire délicat ; vous ne devriez pas modifier __hash__

sans également modifier __eq__. Si vous n’êtes pas sûr de ce

que vous faites, une lecture supplémentaire est suggérée.

"Python Hashes and Equality" par notre réviseur technique

Hynek Schlawack est un bon point de départ.

|

1.4. Tout ne doit pas être un objet : une fonction de Service de Domaine

Nous avons créé un modèle pour représenter les lots, mais ce que nous devons réellement faire est d’allouer des lignes de commande contre un ensemble spécifique de lots qui représentent tout notre stock.

Parfois, ce n’est tout simplement pas une chose.

Domain-Driven Design

Evans discute de l’idée d’opérations de Service de Domaine qui n’ont pas de place naturelle dans une entité ou un objet valeur.[8] Une chose qui alloue une ligne de commande, étant donné un ensemble de lots, ressemble beaucoup à une fonction, et nous pouvons profiter du fait que Python est un langage multiparadigme et simplement en faire une fonction.

Voyons comment nous pourrions tester une telle fonction :

def test_prefers_current_stock_batches_to_shipments():

in_stock_batch = Batch("in-stock-batch", "RETRO-CLOCK", 100, eta=None)

shipment_batch = Batch("shipment-batch", "RETRO-CLOCK", 100, eta=tomorrow)

line = OrderLine("oref", "RETRO-CLOCK", 10)

allocate(line, [in_stock_batch, shipment_batch])

assert in_stock_batch.available_quantity == 90

assert shipment_batch.available_quantity == 100

def test_prefers_earlier_batches():

earliest = Batch("speedy-batch", "MINIMALIST-SPOON", 100, eta=today)

medium = Batch("normal-batch", "MINIMALIST-SPOON", 100, eta=tomorrow)

latest = Batch("slow-batch", "MINIMALIST-SPOON", 100, eta=later)

line = OrderLine("order1", "MINIMALIST-SPOON", 10)

allocate(line, [medium, earliest, latest])

assert earliest.available_quantity == 90

assert medium.available_quantity == 100

assert latest.available_quantity == 100

def test_returns_allocated_batch_ref():

in_stock_batch = Batch("in-stock-batch-ref", "HIGHBROW-POSTER", 100, eta=None)

shipment_batch = Batch("shipment-batch-ref", "HIGHBROW-POSTER", 100, eta=tomorrow)

line = OrderLine("oref", "HIGHBROW-POSTER", 10)

allocation = allocate(line, [in_stock_batch, shipment_batch])

assert allocation == in_stock_batch.referenceEt notre service pourrait ressembler à ceci :

def allocate(line: OrderLine, batches: List[Batch]) -> str:

batch = next(b for b in sorted(batches) if b.can_allocate(line))

batch.allocate(line)

return batch.reference1.4.1. Les méthodes magiques de Python nous permettent d’utiliser nos modèles avec un Python idiomatique

Vous pouvez aimer ou non l’utilisation de next() dans le code précédent, mais nous sommes assez

sûrs que vous serez d’accord que pouvoir utiliser sorted() sur notre liste de

lots est agréable, un Python idiomatique.

Pour que cela fonctionne, nous implémentons __gt__ sur notre modèle de domaine :

class Batch:

...

def __gt__(self, other):

if self.eta is None:

return False

if other.eta is None:

return True

return self.eta > other.etaC’est charmant.

1.4.2. Les exceptions peuvent aussi exprimer des concepts du domaine

Nous avons un dernier concept à couvrir : les exceptions peuvent être utilisées pour exprimer des concepts du domaine aussi. Dans nos conversations avec les experts du domaine, nous avons appris la possibilité qu’une commande ne puisse pas être allouée parce que nous sommes en rupture de stock, et nous pouvons capturer cela en utilisant une exception de domaine :

def test_raises_out_of_stock_exception_if_cannot_allocate():

batch = Batch("batch1", "SMALL-FORK", 10, eta=today)

allocate(OrderLine("order1", "SMALL-FORK", 10), [batch])

with pytest.raises(OutOfStock, match="SMALL-FORK"):

allocate(OrderLine("order2", "SMALL-FORK", 1), [batch])Nous ne vous ennuierons pas trop avec l’implémentation, mais la principale chose à noter est que nous prenons soin de nommer nos exceptions dans le langage omniprésent, tout comme nous le faisons pour nos entités, objets valeur et services :

class OutOfStock(Exception):

pass

def allocate(line: OrderLine, batches: List[Batch]) -> str:

try:

batch = next(

...

except StopIteration:

raise OutOfStock(f"Out of stock for sku {line.sku}")Notre modèle de domaine à la fin du chapitre est une représentation visuelle de où nous en sommes arrivés.

Cela suffira probablement pour l’instant ! Nous avons un service de domaine que nous pouvons utiliser pour notre premier cas d’utilisation. Mais d’abord nous aurons besoin d’une base de données…

2. Pattern Repository (Dépôt)

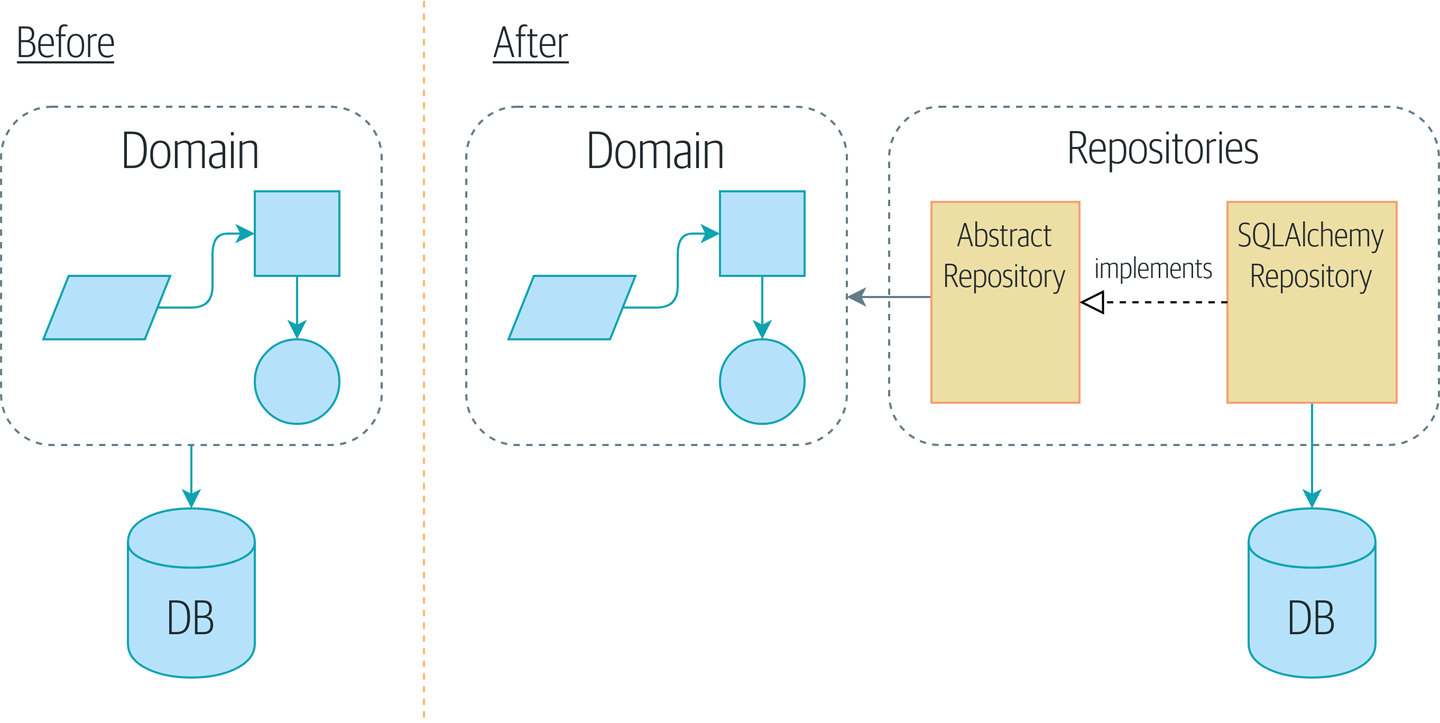

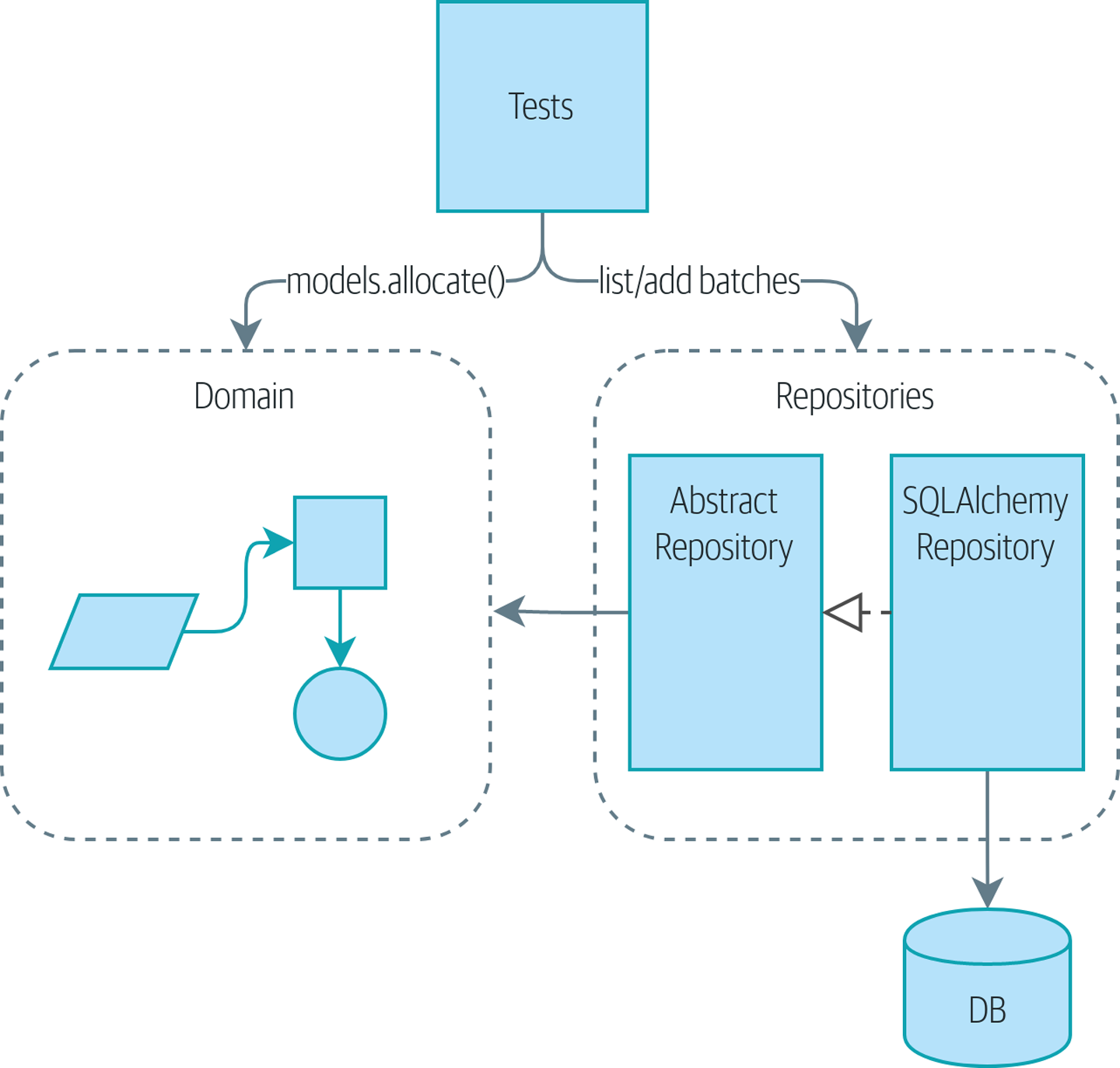

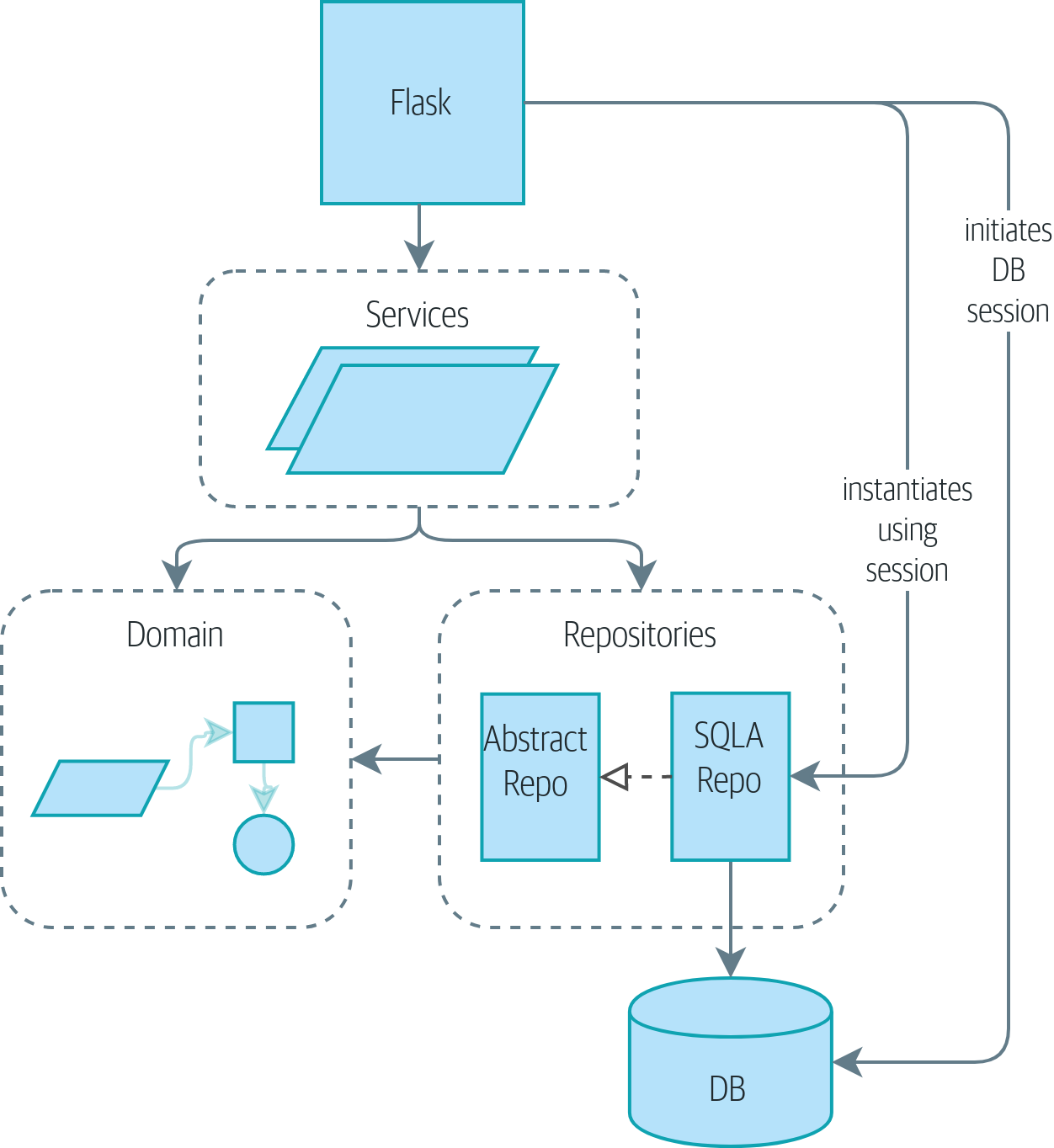

Il est temps de tenir notre promesse d’utiliser le principe d’inversion des dépendances comme moyen de découpler notre logique métier des préoccupations d’infrastructure.

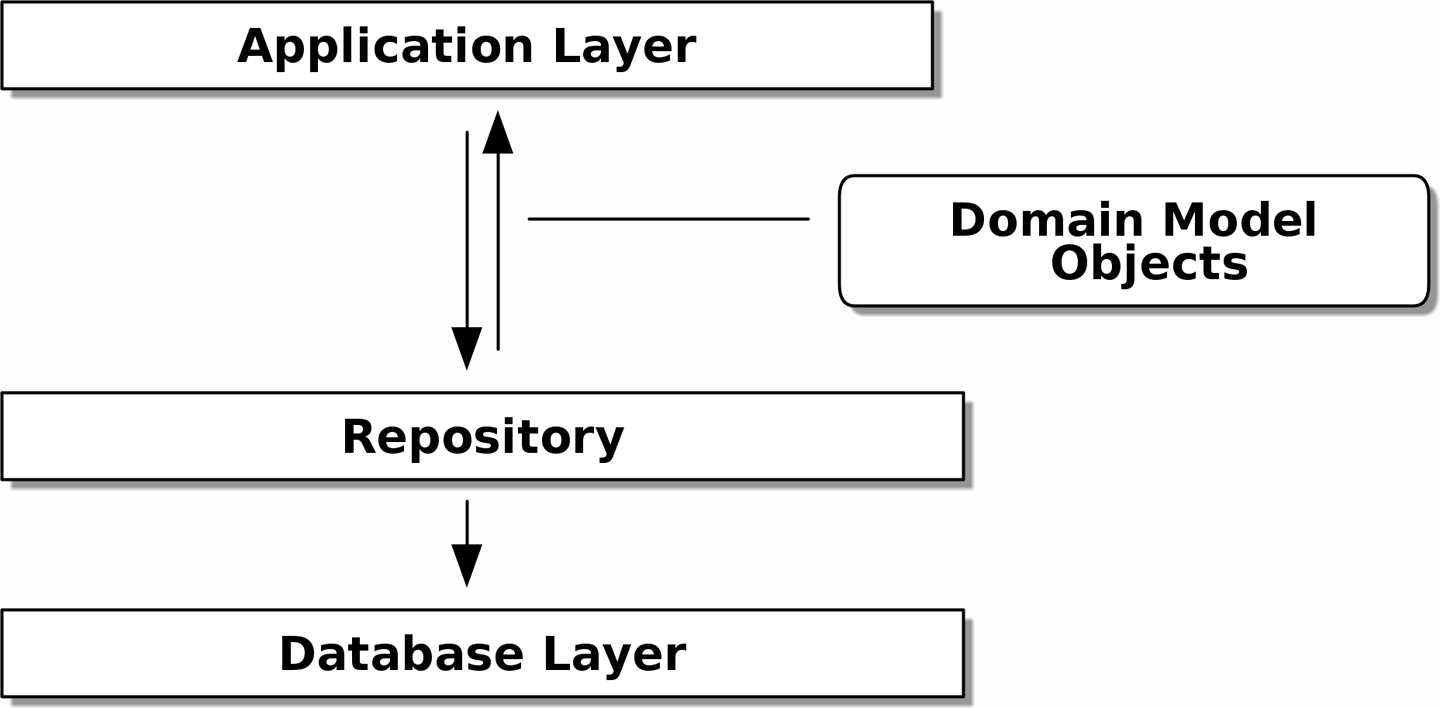

Nous allons introduire le pattern Repository (Dépôt), une abstraction simplificatrice du stockage de données, nous permettant de découpler notre couche modèle de la couche de données. Nous présenterons un exemple concret de la façon dont cette abstraction simplificatrice rend notre système plus testable en cachant les complexités de la base de données.

Avant et après le pattern Repository montre un petit aperçu de ce que nous allons construire : un objet Repository qui se situe entre notre modèle de domaine et la base de données.

|

Le code de ce chapitre se trouve dans la branche chapter_02_repository sur GitHub. git clone https://github.com/cosmicpython/code.git cd code git checkout chapter_02_repository # ou pour coder en suivant, récupérez le chapitre précédent : git checkout chapter_01_domain_model |

2.1. Rendre Persistant Notre Modèle de Domaine

Dans Modélisation du Domaine nous avons construit un simple modèle de domaine qui peut allouer des commandes à des lots de stock. Il est facile pour nous d’écrire des tests contre ce code car il n’y a aucune dépendance ou infrastructure à mettre en place. Si nous devions exécuter une base de données ou une API et créer des données de test, nos tests seraient plus difficiles à écrire et à maintenir.

Malheureusement, à un moment donné, nous devrons mettre notre petit modèle parfait entre les mains des utilisateurs et composer avec le monde réel des feuilles de calcul, des navigateurs web et des conditions de concurrence. Pour les prochains chapitres, nous allons examiner comment nous pouvons connecter notre modèle de domaine idéalisé à un état externe.

Nous nous attendons à travailler de manière agile, donc notre priorité est d’arriver à un produit minimum viable le plus rapidement possible. Dans notre cas, ce sera une API web. Dans un projet réel, vous pourriez vous lancer directement avec des tests de bout en bout et commencer à brancher un framework web, en développant de l’extérieur vers l’intérieur par les tests.

Mais nous savons que, quoi qu’il arrive, nous allons avoir besoin d’une forme de stockage persistant, et ceci est un manuel, donc nous pouvons nous permettre un peu plus de développement ascendant et commencer à réfléchir au stockage et aux bases de données.

2.2. Un Peu de Pseudo-Code : De Quoi Allons-Nous Avoir Besoin ?

Quand nous construirons notre premier point de terminaison API, nous savons que nous allons avoir du code qui ressemble plus ou moins à ceci.

@flask.route.gubbins

def allocate_endpoint():

# extraire la ligne de commande de la requête

line = OrderLine(request.params, ...)

# charger tous les lots depuis la BD

batches = ...

# appeler notre service de domaine

allocate(line, batches)

# puis sauvegarder l'allocation dans la base de données d'une manière ou d'une autre

return 201| Nous avons utilisé Flask car c’est léger, mais vous n’avez pas besoin d’être un utilisateur de Flask pour comprendre ce livre. En fait, nous vous montrerons comment faire de votre choix de framework un détail mineur. |

Nous aurons besoin d’un moyen de récupérer les informations sur les lots depuis la base de données et d’instancier nos objets du modèle de domaine à partir de celles-ci, et nous aurons également besoin d’un moyen de les sauvegarder dans la base de données.

Quoi ? Oh, "gubbins" est un mot britannique pour "trucs". Vous pouvez simplement l’ignorer. C’est du pseudo-code, OK ?

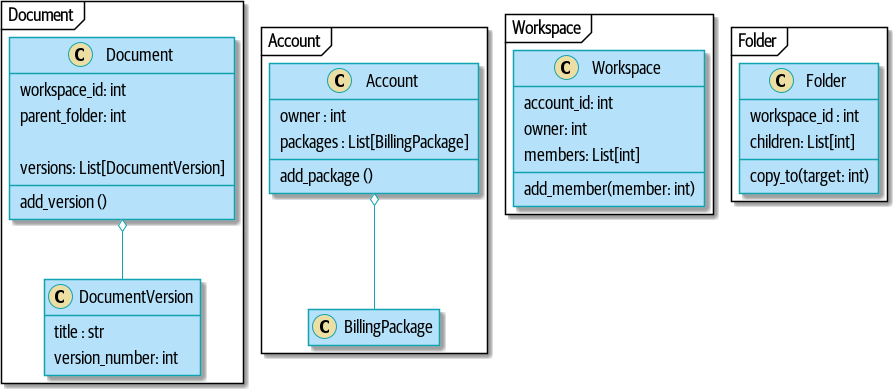

2.3. Appliquer le DIP à l’Accès aux Données

Comme mentionné dans l’introduction, une architecture en couches (layered architecture) est une approche courante pour structurer un système qui a une interface utilisateur, de la logique et une base de données (voir Architecture en couches).

La structure Modèle-Vue-Template de Django est étroitement liée, tout comme le Modèle-Vue-Contrôleur (MVC). Dans tous les cas, l’objectif est de garder les couches séparées (ce qui est une bonne chose), et de faire en sorte que chaque couche ne dépende que de celle en dessous.

Mais nous voulons que notre modèle de domaine n’ait aucune dépendance quelle qu’elle soit.[9] Nous ne voulons pas que les préoccupations d’infrastructure contaminent notre modèle de domaine et ralentissent nos tests unitaires ou notre capacité à apporter des modifications.

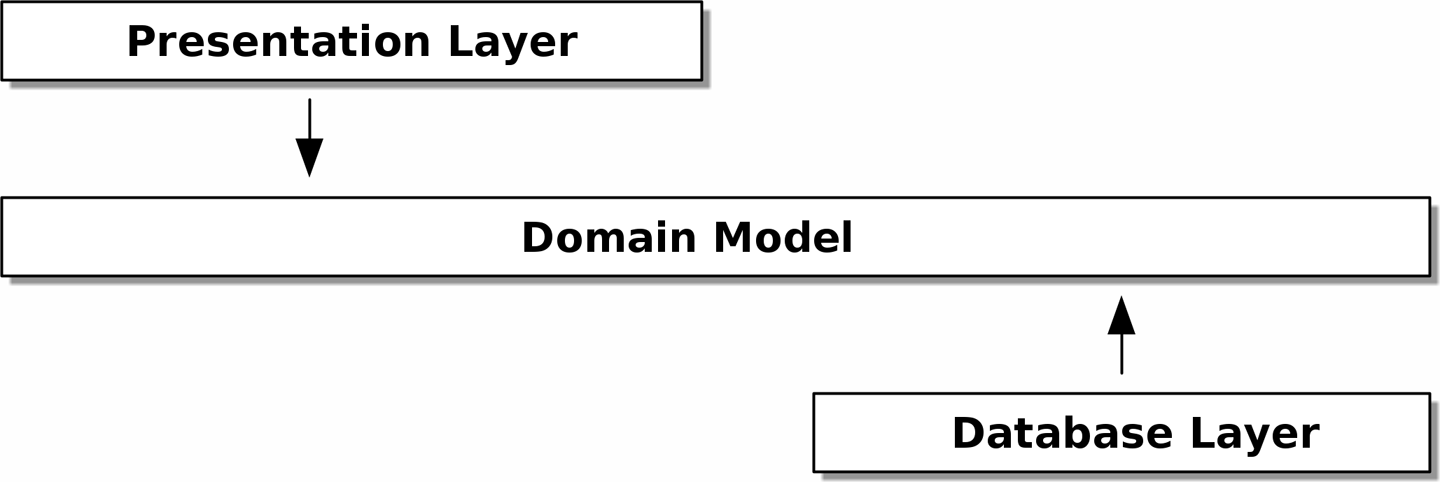

Au lieu de cela, comme discuté dans l’introduction, nous considérerons notre modèle comme étant à "l’intérieur", et les dépendances affluant vers lui ; c’est ce que les gens appellent parfois architecture en oignon (onion architecture) (voir Architecture en oignon).

[ditaa, apwp_0203]

+------------------------+

| Presentation Layer |

+------------------------+

|

V

+--------------------------------------------------+

| Domain Model |

+--------------------------------------------------+

^

|

+---------------------+

| Database Layer |

+---------------------+

2.4. Rappel : Notre Modèle

Rappelons-nous notre modèle de domaine (voir Notre modèle) : une allocation est le concept de lier une OrderLine à un Batch. Nous stockons les allocations comme une collection sur notre objet Batch.

Voyons comment nous pourrions traduire cela en une base de données relationnelle.

2.4.1. La Méthode ORM "Normale" : Le Modèle Dépend de l’ORM

De nos jours, il est peu probable que les membres de votre équipe écrivent leurs propres requêtes SQL à la main. Au lieu de cela, vous utilisez presque certainement une sorte de framework pour générer du SQL pour vous en fonction de vos objets modèle.

Ces frameworks sont appelés mappeurs objet-relationnel (object-relational mappers - ORMs) parce qu’ils existent pour combler le fossé conceptuel entre le monde des objets et de la modélisation de domaine et le monde des bases de données et de l’algèbre relationnelle.

La chose la plus importante qu’un ORM nous apporte est l’ignorance de la persistance (persistence ignorance) : l’idée que notre modèle de domaine sophistiqué n’a pas besoin de savoir quoi que ce soit sur la façon dont les données sont chargées ou rendues persistantes. Cela aide à garder notre domaine exempt de dépendances directes sur des technologies de base de données particulières.[11]

Mais si vous suivez le tutoriel SQLAlchemy typique, vous vous retrouverez avec quelque chose comme ceci :

from sqlalchemy import Column, ForeignKey, Integer, String

from sqlalchemy.ext.declarative import declarative_base

from sqlalchemy.orm import relationship

Base = declarative_base()

class Order(Base):

id = Column(Integer, primary_key=True)

class OrderLine(Base):

id = Column(Integer, primary_key=True)

sku = Column(String(250))

qty = Integer(String(250))

order_id = Column(Integer, ForeignKey('order.id'))

order = relationship(Order)

class Allocation(Base):

...Vous n’avez pas besoin de comprendre SQLAlchemy pour voir que notre modèle immaculé est maintenant plein de dépendances sur l’ORM et commence à avoir l’air sacrément laid en plus. Pouvons-nous vraiment dire que ce modèle est ignorant de la base de données ? Comment peut-il être séparé des préoccupations de stockage quand les propriétés de notre modèle sont directement couplées aux colonnes de la base de données ?

2.4.2. Inverser la Dépendance : L’ORM Dépend du Modèle

Eh bien, heureusement, ce n’est pas la seule façon d’utiliser SQLAlchemy. L’alternative est de définir votre schéma séparément, et de définir un mapper explicite pour comment convertir entre le schéma et notre modèle de domaine, ce que SQLAlchemy appelle un mappage classique (classical mapping) :

from sqlalchemy.orm import mapper, relationship

import model (1)

metadata = MetaData()

order_lines = Table( (2)

"order_lines",

metadata,

Column("id", Integer, primary_key=True, autoincrement=True),

Column("sku", String(255)),

Column("qty", Integer, nullable=False),

Column("orderid", String(255)),

)

...

def start_mappers():

lines_mapper = mapper(model.OrderLine, order_lines) (3)| 1 | L’ORM importe (ou "dépend de" ou "connaît") le modèle de domaine, et non l’inverse. |

| 2 | Nous définissons nos tables et colonnes de base de données en utilisant les abstractions de SQLAlchemy.[12] |

| 3 | Quand nous appelons la fonction mapper, SQLAlchemy fait sa magie pour lier nos classes du modèle de domaine aux différentes tables que nous avons définies. |

Le résultat final sera que, si nous appelons start_mappers, nous pourrons facilement charger et sauvegarder des instances du modèle de domaine depuis et vers la base de données. Mais si nous n’appelons jamais cette fonction, nos classes du modèle de domaine restent heureusement inconscientes de la base de données.

Cela nous donne tous les avantages de SQLAlchemy, y compris la capacité d’utiliser alembic pour les migrations, et la capacité d’interroger de manière transparente en utilisant nos classes de domaine, comme nous le verrons.

Quand vous essayez pour la première fois de construire votre configuration ORM, il peut être utile d’écrire des tests pour celle-ci, comme dans l’exemple suivant :

def test_orderline_mapper_can_load_lines(session): (1)

session.execute(

"INSERT INTO order_lines (orderid, sku, qty) VALUES "

'("order1", "RED-CHAIR", 12),'

'("order1", "RED-TABLE", 13),'

'("order2", "BLUE-LIPSTICK", 14)'

)

expected = [

model.OrderLine("order1", "RED-CHAIR", 12),

model.OrderLine("order1", "RED-TABLE", 13),

model.OrderLine("order2", "BLUE-LIPSTICK", 14),

]

assert session.query(model.OrderLine).all() == expected

def test_orderline_mapper_can_save_lines(session):

new_line = model.OrderLine("order1", "DECORATIVE-WIDGET", 12)

session.add(new_line)

session.commit()

rows = list(session.execute('SELECT orderid, sku, qty FROM "order_lines"'))

assert rows == [("order1", "DECORATIVE-WIDGET", 12)]| 1 | Si vous n’avez pas utilisé pytest, l’argument session de ce test nécessite une explication. Vous n’avez pas besoin de vous soucier des détails de pytest ou de ses fixtures pour les besoins de ce livre, mais l’explication courte est que vous pouvez définir des dépendances communes pour vos tests comme des "fixtures", et pytest les injectera aux tests qui en ont besoin en regardant leurs arguments de fonction. Dans ce cas, c’est une session de base de données SQLAlchemy.

|

Vous ne garderiez probablement pas ces tests à long terme — comme vous le verrez bientôt, une fois que vous aurez franchi l’étape d’inverser la dépendance de l’ORM et du modèle de domaine, ce n’est qu’une petite étape supplémentaire pour implémenter une autre abstraction appelée le pattern Repository, contre laquelle il sera plus facile d’écrire des tests et qui fournira une interface simple à simuler plus tard dans les tests.

Mais nous avons déjà atteint notre objectif d’inverser la dépendance traditionnelle : le modèle de domaine reste "pur" et libre de préoccupations d’infrastructure. Nous pourrions jeter SQLAlchemy et utiliser un ORM différent, ou un système de persistance totalement différent, et le modèle de domaine n’a pas besoin de changer du tout.

En fonction de ce que vous faites dans votre modèle de domaine, et surtout si vous vous éloignez du paradigme orienté objet, vous pourriez trouver de plus en plus difficile d’obtenir de l’ORM le comportement exact dont vous avez besoin, et vous pourriez avoir besoin de modifier votre modèle de domaine.[13] Comme cela arrive souvent avec les décisions architecturales, vous devrez considérer un compromis. Comme le dit le Zen de Python, "L’aspect pratique bat la pureté !"

À ce stade, cependant, notre point de terminaison API pourrait ressembler à ce qui suit, et nous pourrions le faire fonctionner très bien :

@flask.route.gubbins

def allocate_endpoint():

session = start_session()

# extraire la ligne de commande de la requête

line = OrderLine(

request.json['orderid'],

request.json['sku'],

request.json['qty'],

)

# charger tous les lots depuis la BD

batches = session.query(Batch).all()

# appeler notre service de domaine

allocate(line, batches)

# sauvegarder l'allocation dans la base de données

session.commit()

return 2012.5. Introduction du Pattern Repository

Le pattern Repository (Dépôt) est une abstraction sur le stockage persistant. Il cache les détails ennuyeux de l’accès aux données en faisant semblant que toutes nos données sont en mémoire.

Si nous avions une mémoire infinie dans nos ordinateurs portables, nous n’aurions pas besoin de bases de données maladroites. Au lieu de cela, nous pourrions simplement utiliser nos objets quand nous le voulons. À quoi cela ressemblerait-il ?

import all_my_data

def create_a_batch():

batch = Batch(...)

all_my_data.batches.add(batch)

def modify_a_batch(batch_id, new_quantity):

batch = all_my_data.batches.get(batch_id)

batch.change_initial_quantity(new_quantity)Même si nos objets sont en mémoire, nous devons les mettre quelque part pour pouvoir les retrouver. Nos données en mémoire nous permettraient d’ajouter de nouveaux objets, tout comme une liste ou un ensemble. Parce que les objets sont en mémoire, nous n’avons jamais besoin d’appeler une méthode .save() ; nous récupérons simplement l’objet qui nous intéresse et le modifions en mémoire.

2.5.1. Le Repository dans l’Abstrait

Le dépôt le plus simple n’a que deux méthodes : add() pour mettre un nouvel élément dans le dépôt, et get() pour retourner un élément précédemment ajouté.[14]

Nous nous en tenons rigoureusement à l’utilisation de ces méthodes pour l’accès aux données dans notre domaine et notre couche de service. Cette simplicité auto-imposée nous empêche de coupler notre modèle de domaine à la base de données.

Voici à quoi ressemblerait une classe de base abstraite (ABC) pour notre dépôt :

class AbstractRepository(abc.ABC):

@abc.abstractmethod (1)

def add(self, batch: model.Batch):

raise NotImplementedError (2)

@abc.abstractmethod

def get(self, reference) -> model.Batch: